Actualités du mois de novembre 2011

Outre la version Windows de son Kinect, Microsoft travaillerait actuellement à la version 2 de l'appareil, qui sera destiné à la prochaine génération de Xbox, attendue pour 2012 ou 2013. Un nouveau Kinect qui serait beaucoup plus performant que l'actuel...

En effet, si le concept de Kinect est intéressant, il souffre encore parfois d'un manque de réactivité, mais aussi d'une capacité de reconnaissance limitée, qui ne permet pas d'exploiter tout le potentiel du concept. Mais selon des fuites provenant de l'équipe de développement, Kinect 2 améliorerait grandement les choses. Le nouvel appareil serait par exemple en mesure de reconnaitre les émotions des joueurs grâce à l'analyse de leurs expressions faciales et du ton de leur voix. Il serait même capable de lire sur les lèvres.

Pour rappel, le Kinect est un périphérique pour Xbox 360 qui, grâce à un jeu de caméras, détecte les mouvements et la position du joueur pour les retranscrire en actions dans les jeux. Avec un système plus efficace, il sera donc possible de rendre les jeux encore plus immersifs. On pourrait par exemple envisager des jeux de tirs où le viseur passerait en mode sniper lorsque le joueur ferme un œil, ou encore des jeux de rôle où les émotions du joueur seraient retranscrites en temps réel sur son avatar.

Posté par Matt le 30/11/2011 à 13h10

Aucun commentaire

Source : Übergizmo

Introduite il y a quelques années avec un débit de 3.6 Mbit/s, la 3G+ a depuis beaucoup évolué. Avec les dernières évolutions, le HSPA+ permet d'atteindre un débit de 42 Mbit/s sur deux porteuses. Une technologie qu'Orange a commencé à déployer sur son réseau, emboîtant le pas à SFR et Bouygues Telecom.

Activé depuis le 24 novembre dans neuf grandes agglomérations françaises (Grenoble, Île de France, Lens, Lille, Lyon, Marseille, Nantes, Nice et Toulon), cette technologie couvrirait déjà 50% de la population selon Orange, qui vise 60% dans six mois (en ajoutant à la liste Bordeaux, Strasbourg et Toulouse), puis l'ensemble du territoire (hum...) début 2013.

Dans un premier temps, ces débits sont réservés aux forfait les plus haut de gamme de l'opérateur, qui proposera aussi de nouveaux terminaux compatibles avec ces débits, notamment la clé Huawei E372, déjà disponible chez SFR. Du côté des smartphones, il faudra encore patienter, l'iPhone 4S d'Apple ne dépasse pas les 14.4 Mbit/s, tandis que le Samsung Galaxy Nexus plafonne à 21 Mbit/s

Il sera intéressant de voir si les futurs abonnés Free Mobile auront aussi droit à ces débits lorsqu'il seront en roaming sur le réseau d'Orange, ou s'il ne pourront en profiter que sur le réseau Free Mobile, qui devrait probablement supporter lui aussi le HSPA+.

Posté par Matt le 30/11/2011 à 10h51

Aucun commentaire

Source : Business Mobile

Outre les tablettes et les smartphones, Canonical chercherait à décliner sa distribution Linux Ubuntu sur les télévisions connectées, à partir de la version 14.04 LTS qui sortira dans un peu plus de deux ans.

Mark Shuttleworth, fondateur de la société, a en effet publié sur son blog les premières ébauches de design d'"Ubuntu TV". L'interface graphique sera, sans surprise, dérivée de l'interface Unity proposée par Ubuntu depuis un peu plus d'un an. Elle sera notamment adaptée pour faciliter son pilotage à partir d'une télécommande.

La distribution sera bien sûr orientée vers le multimédia, et gérera donc nativement de nombreux supports, y compris les Blu-ray. Elle devrait aussi permettre d'accéder au service Ubuntu One, voir à des boutiques de contenus, telles qu'Amazon ou Netflix et à des réseaux sociaux.

Espérons toutefois que cette diversification d'Ubuntu ne se fera pas au détriment de la version Desktop...

Posté par Matt le 30/11/2011 à 08h13

Aucun commentaire

Source : Génération NT

![]()

Dans une interview accordée à Électron Libre, Fleur Pellerin, conseillère de François Hollande sur les questions numériques, a clarifié la position du candidat socialiste à la présidentielle de 2012 au sujet d'Hadopi : une abrogation suivie d'une recréation quasi à l'identique...

En effet, s'il considère toujours que l'Hadopi doit être abrogée du fait de son inefficacité, le candidat aurait pour idée de remplacer l'Hadopi par une "une instance de protection du droit d’auteur, dont les missions de contrôle et d'avertissement seraient la contrepartie d’une gestion concertée de la propriété intellectuelle et du développement de l'offre légale". Bref, remplacer l'Hadopi par... l'Hadopi. Même le principe des Labs Hadopi, qui visent à étudier les nouvelles pratiques d'Internet et du monde de la création artistique serait repris à son compte par le socialiste : "cette instance pourrait également être un « think tank » sur la création, l'évolution des usages et des pratiques d’internet".

Cette instance serait mise en place en concertation avec les ayants-droit, les sociétés de gestion de droits d'auteurs (SACEM et cie), les producteurs et le public (probablement représenté par les associations de consommateurs), ce qui promet sans doute une instance très orientée en faveur des ayant-droit. Une solution qui risque donc d'être bien éloignée du projet de légalisation des échanges non marchants prôné par le programme officiel du Parti Socialiste. Programme que François Hollande ne semble pas vouloir suivre sur ce point...

Posté par Matt le 29/11/2011 à 14h22

Aucun commentaire

Source : Numerama

Quelques mois après son abandon par Mindscape, une nouvelle vie devrait prochainement commencer pour le petit lapin communicant, grâce au française Aldebaran Robotics, qui vient d'annoncer avoir repris le bébé.

Déjà connu pour son robot NAO, qui avait notamment permis de débloquer une grosse subvention d'Intel, Aldebaran Robotics promet la mise en place de nouveaux serveurs pour héberger les services existants, en se basant sur le code libéré par Mindscape, mais annonce aussi le développement de nouveaux services pour les modèles les plus récents, et notamment des services de reconnaissance et de synthèse vocale. À quand Siri sur Nabaztag ?

Aldebaran n'a par contre pas encore indiqué de date précise pour le lancement de ces nouveaux serveurs, et, malheureusement pour les fans du Nabaztag, n'a pour l'instant pas évoqué l'arrivée de nouveaux produits dans la gamme. Mais le simple fait de fournir à nouveau les services indispensables au fonctionnement de la bête devrait déjà ravir les propriétaires, dont le lapin était pour l'instant devenu un onéreux presse-papier.

Espérons pour Aldebaran Robotics que la société ne connaitra pas le même sort que les deux précédents éleveurs de lapins, Violet et Mindscape.

Posté par Matt le 29/11/2011 à 13h10

Aucun commentaire

Source : PCWorld

Outre le problème de la capacité et du temps de charge, qui freine les possibilités, les batteries actuelles souffrent généralement d'une durée de vie assez limitée, qui dépasse rarement les 1000 cycles de charge/décharge. Mais les chercheurs de Stanford seraient sur le point de trouver une solution.

Une équipe de chercheurs de la prestigieuse Université de Stanford (Californie) a en effet réussi à multiplier par 100 le nombre de cycles que peut tolérer une batterie, passant de 400 à 40 000 cycles. Pour ce faire, ils ont simplement remplacé les électrodes classiques par des électrodes en hexacyanoferrate de cuivre. Les électrodes ainsi réalisées s'usent bien moins au fil des charges/décharges, d'où le gain sur la durée de vie de la batterie.

Selon les chercheurs, cette nouvelle technologie aurait de plus l'avantage d'être très peu onéreuse à la fabrication, engendrant donc un surcoût minime à la production. Par contre, le procédé n'est malheureusement pas encore parfaitement au point, et il faudra donc encore patienter avant d'arriver à une solution industrialisable. Il faudra aussi que les constructeurs soient intéressés par cette technologie, qui pourrait fortement freiner les ventes de batteries...

Posté par Matt le 29/11/2011 à 10h41

5 commentaires

Source : Génération NT

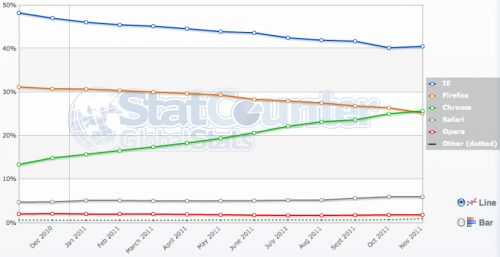

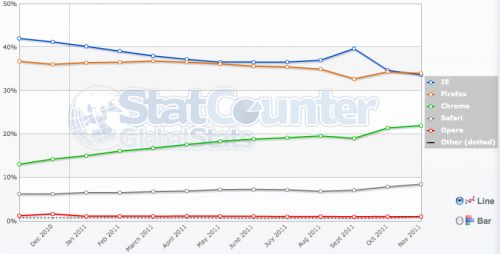

Bien aidé par la machine marketing de Google, Chrome connait une croissance continue et rapide de sa part de marché depuis son lancement. Il vient de passer une étape symbolique, en dépassant la part de marché de Firefox au niveau mondial.

En effet, pendant que le panda roux perdait petit à petit du terrain, passant de 31 à 25% du marché, Chrome est passé de 13 à 26%, ce qui lui permet d'occuper désormais la seconde place, derrière Internet Explorer, toujours largement en tête (40%), même s'il a lui aussi beaucoup perdu depuis un an (il était alors à 48% du marché). Safari conserve sa quatrième place, avec environ 6% du marché (4.4% il y a un an), tandis qu'Opera stagne toujours en cinquième position, avec une part de marché qui ne décolle pas des 2%. À ce train là, Chrome pourrait devenir le navigateur le plus utilisé dès l'année prochaine. Il y a toutefois fort à parier que la croissance de son utilisation finira par ralentir, ce qui pourrait accorder un petit sursis à Internet Explorer.

Sur le marché français, la situation est moins favorable à Chrome. Sil était aussi à 13% environ il y a un an, il n'a gagné que 9 points. Pas assez pour passer devant Firefox (34% contre 37% il y a un an), qui devient le navigateur le plus utilisé, avec une toute petite longueur d'avance sur Internet Explorer (33.6% contre 42% il y a un an). Safari atteint pour sa part les 9% (6% il y a un an), tandis qu'Opera doit se contenter des miettes, avec à peine 1% du marché français.

Posté par Matt le 29/11/2011 à 08h12

16 commentaires

Source : Clubic

La concurrence a du bon : alors qu'il y a une grosse dizaine d'année, une version de base d'Office était facturée plusieurs centaines d'euros par Microsoft, l'éditeur vient de rendre gratuite la version d'entrée de gamme de sa suite bureautique, Office 2010 Starter Edition.

Jusqu'à présent proposée uniquement en version OEM aux constructeurs d'ordinateurs, Office 2010 Starter Edition ne contient que Word et Excel, dans des versions amputées d'une partie de leurs fonctions avancées. Les deux logiciels intègrent également un bandeau publicitaire.

Les utilisateurs avancés devront continuer à se tourner vers la version complète de la suite, ou éventuellement vers des alternatives libres, mais la Starter Edition devrait faire l'affaire pour la plupart des particuliers, et garantir une parfaite compatibilité avec les versions payantes.

Pour le téléchargement, ça se passe par ici.

Posté par Matt le 28/11/2011 à 12h40

1 commentaire

Source : Génération NT

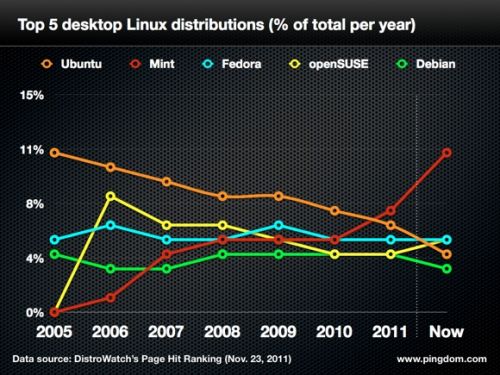

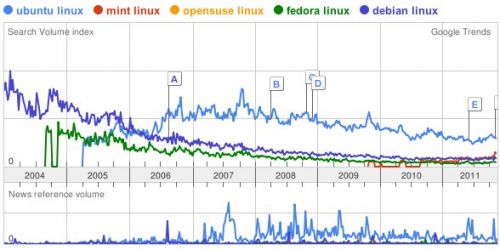

Distribution Linux la plus populaire depuis plusieurs années, Ubuntu intéressait de moins en moins les utilisateurs depuis 2005. Une chute de popularité qui s'est accélérée en 2011, à tel point qu'Ubuntu ne serait désormais plus que la 4ème distribution Linux la plus attrayante. à tel point qu'Ubuntu ne serait désormais plus que la 4ème distribution Linux.

C'est désormais la distribution Mint qui, bien que beaucoup moins connue du grand public, est celle qui intéresse le plus les connaisseurs : elle atteindrait 11% des recherche sur Distrowatch, alors qu'Ubuntu, qui était concernée par 11% des recherches en 2005 est tombée à un peu plus de 4%. Entre les deux, on trouve Fedora et openSUSE, toutes deux à environ 5%.

Il ne serait pas surprenant que cette soudaine croissance de Mint soit liée à un rejet de l'interface Unity que propose désormais Ubuntu. En effet, Mint est une distribution basée sur Ubuntu, mais qui conserve des interfaces plus classiques. Certains habitués d'Ubuntu sont dont peut-être en train de regarder si l'herbe est plus verte du côté de Mint...

Du côté de Google, avec une audience plus grand public, on peut également constater une baisse de la popularité d'Ubuntu au profit de Mint. Mais la distribution de Canonical reste tout de même assez nettement en tête. Canonical a donc encore un peu de marge de manœuvre pour relancer la machine, mais a intérêt à ne pas trop se reposer sur ses lauriers.

Posté par Matt le 28/11/2011 à 10h30

3 commentaires

Source : Numérama

Pour lutter contre la fracture numérique, le député centriste Hervé Maurey vient de déposer une proposition de loi visant à imposer aux opérateurs de permettre l'accès à tout citoyen français à un débit d'au moins 2 Mbit/s dès l'année prochaine, puis 8 Mbit/s en 2015.

Un calendrier tout de même un peu ambitieux, sachant qu'aujourd'hui 23% des foyers n'ont pas encore accès au 2 Mbit/s. Le sénateur ne s'attaque pas qu'au problème de la couverture Internet, mais aussi à celui de la couverture mobile : il estime que le système actuel de mesure de la couverture est trompeur et donne l'impression d'un taux de couverture bien supérieur à celui constaté en pratique. Il est vrai qu'en mesurant la couverture en pourcentage de la population plutôt qu'en pourcentage du territoire, il est plus facile d'obtenir des taux approchant les 100%...

Comme il faudra de l'argent pour financer les nouvelles infrastructures nécessaires à améliorer ces couvertures, les sénateur propose - comme c'est original - une nouvelle taxe sur les abonnements à Internet, la "contribution de solidarité numérique". Cette taxe pourrait aussi s'appliquer aux téléviseurs et aux consoles de jeu...

Posté par Matt le 28/11/2011 à 08h13

Aucun commentaire

Source : 01Net

Il y a quelques jours seulement, l'ARCEP a imposé aux opérateurs mobiles un délai de portage des numéros d'un maximum de trois jours ouvrés, contre dix jours jusqu'à présent. Mais ce délai va encore être revu à la baisse dans les semaines à venir.

En effet, malgré cette forte baisse du délai, la France et 15 autres pays membres de l'Union Européenne n'est pas en conformité avec les nouvelles règles communautaires en la matière qui, dans l'intérêt du consommateur (qui paie ses deux abonnements mobiles pendant la durée du portage), exigent que le portage soit effectué en à peine une journée.

La France dispose de deux mois pour se mettre en conformité. Selon Les Echos, ceci devrait être fait dans les temps, tous les décrets nécessaires à la mise en place de cette règle devant être adoptés d'ici peu.

Avec l'arrivée prochaine de Free Mobile sur le marché, cette réduction du délai sera sans doute la bienvenue pour bon nombres d'abonnés mobiles.

Posté par Matt le 25/11/2011 à 10h15

7 commentaires

Source : Univers Freebox

Saisie par le fournisseur d'accès belge Scarlet Extended, la Cour de Justice de l'Union Européenne vient de rendre une décision qui va faire le bonheur des défenseurs des libertés individuelles sur Internet, puisqu'elle interdit toute mesure de filtrage imposée par une autorité locale.

Scarlet avait décidé de saisir la CJUE après avoir été condamné par un tribunal belga à filtrer les échanges illégaux par P2P suite à une plainte de la Sabam (équivalent belge de la Sacem). Considérant qu'un tel filtrage global serait un frein à la liberté d'entreprendre en imposant de lourdes et coûteuses infrastructures aux FAI et une atteinte au droits fondamentaux des abonnés, avec le risque de mener à une surveillance générale, la CJUE a décidé de donner raison à Scarlet : "Le droit de l'Union s'oppose à une injonction, prise par une juridiction nationale, d'imposer à un fournisseur d'accès à Internet la mise en place d'un système de filtrage afin de prévenir les téléchargements illégaux de fichiers."

La nouvelle risque par ailleurs de ne pas faire plaisir au pouvoir français, qui planchait déjà sur un projet de loi HADOPI 3 visant justement à mettre en place du filtrage pour bloquer les sites de streaming.

Posté par Matt le 25/11/2011 à 08h38

Aucun commentaire

Source : Génération NT

Si la Chine reste un pays au niveau de vie plus faible que dans les pays occidentaux, ce niveau de vie croit rapidement, et la population importante de la Chine fait que le nombre de Chinois bénéficiant d'un niveau de vie "occidental" est déjà plus que significatif. Une situation de plus en plus visible dans les ventes de produits hi-tech.

Ainsi, alors que le dernier rapport trimestriel d'Apple montrait déjà qu'une part importante de la croissance des ventes provenait de la Chine, une étude de Strategy Analytics montre que depuis le troisième trimestre 2011, la Chine est devenu le premier marché mondial pour la vente de smartphones, avec 23.9M d'unités vendues (en hausse de 57.5% sur un an) soit 600 000 de plus qu'aux États-Unis, qui deviennent le second marché, avec une baisse des ventes de 7% sur un an.

Ce boom du smartphone profite pour l'instant surtout à Nokia et Samsung, qui, avec 6.8M (+28.5%) et 4.2M (+17.6%) d'unités occupent les deux premières places, mais les fabricants Chinois pourraient les rattraper rapidement vu leurs taux de croissance : ZTE à quasiment doublé ses ventes (+95%) tandis que celles d'Huawei ont augmenté de 80%.

Posté par Matt le 24/11/2011 à 14h51

Aucun commentaire

Source : PCInpact

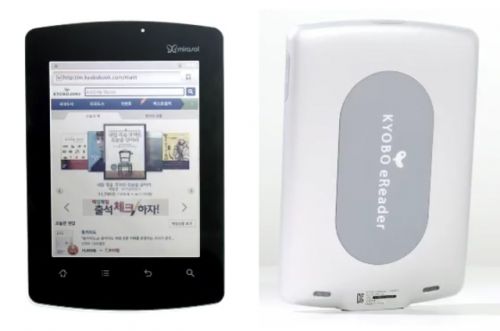

Depuis l'arrivée des tablettes, les lecteurs d'e-books ont perdu beaucoup de leur attrait. Face aux écrans LCD aux couleurs chatoyantes proposées par les tablettes, les écrans e-ink en niveau de gris très peu contrastés sont effectivement bien fades, empêchant d'utiliser ces appareils pour la lecture de BD, de magazines ou de sites web. Mais l'heure de la revanche à sonnée avec l'arrivée des écrans Mirasol.

Présentée par Qualcomm il y a plus d'un an, la technologie Mirasol repose sur un principe proche de celui mis en œuvre dans les écrans e-ink : des éléments de couleurs "mécaniques" dont la capacité à renvoyer ou non la lumière peut être modifiée par le circuit électronique de l'écran. Dans l'e-ink, il s'agit de billes avec une face blanche et une face noire, dans Mirasol il s'agit d'éléments de couleurs qui renvoient plus ou moins la lumière en fonction de leur distance par rapport à la surface de la dalle, distance contrôlée par des MEMS.

Dans les deux cas, on obtient un écran fonctionnant sans rétroéclairage et ne consommant de l'énergie que lors du changement d'état des pixels et parfaitement lisibles en pleine lumière, mais en perdant par contre en contraste et en réactivité par rapport aux écrans LCD ou OLED, ce qui les limite aux contenus peu animés. C'est donc idéal pour la lecture, l'absence de rétroéclairage limitant également la fatigue visuelle.

Très attendus dans les lecteurs d'e-books, les écrans Mirasol commencent enfin à arriver. C'est le Coréen Kyobo qui dégaine le premier produit basé sure cette technologie, le Kyobo eReader, qui est d'ores et déjà disponible dans son pays natal pour environ 230€, avec quelques mois d'avance sur le planning de Qualcomm pour l'application commerciale de sa technologie.

Doté d'un écran de 5.7" d'une définition de 1024x768, l'écran est selon Kyobo suffisamment réactif pour permettre de lire des vidéos. L'appareil est d'ailleurs équipé en conséquence, puisqu'il embarque un processeur double-cœur Qualcomm SnapDragon S2 à 1.2 GHz et fonctionne sous une version modifiée d'Android 2.3/Gingerbread. Grâce à son écran Mirasol, il atteint plusieurs semaines d'autonomie.

Voilà qui augure pour 2012 une belle bataille entre les tablettes traditionnelles, plus polyvalentes mais moins autonomes, et les lecteurs d'e-books, qui vont multiplier leurs usages grâce aux écrans couleurs.

Posté par Matt le 24/11/2011 à 12h31

Aucun commentaire

Source : PCWorld

Alors que le gouvernement avait décidé d'alléger de 30% le barème de la contribution des opérateurs de télécommunications au Centre National du Cinéma, le sénat ne voit pas les choses du même œil et à retiré cette proposition lors de l'examen du budget 2012.

Cet allégement avait été consenti par le gouvernement pour compenser partiellement l'élargissement de l'assiette depuis la suppression de la TVA à taux réduit sur une partie des abonnements en début d'année (l'assiette était alors passée de la part de l'abonnement soumise à la TVA 5.5% à l'intégralité de l'abonnement, soit le plus souvent une assiette doublée).

Si cette proposition du sénat était validée, les opérateurs, déjà excédés par la multiplication des taxes sur leur activité risquent de mal digérer la pilule : leur contribution au CNC, qui aurait déjà dû passer de 190 millions d'euros annuels à 310 millions d'euros avec l'élargissement de l'assiette et la diminution du barème atteindra plus de 400 millions d'euros sans l'allègement du barème.

Espérons que le souvenir des résiliations de début 2010 suffira à faire penser aux opérateurs que la répercussion directe des nouvelles taxes sur la facture des abonnés n'est pas une bonne idée...

Posté par Matt le 24/11/2011 à 10h30

1 commentaire

Source : Univers Freebox

Alors que les connexions Ethernet 10 Gbit/s commencent lancement à se démocratiser, le japonais Rohm promet déjà une technologie offrant un débit trois fois supérieur et sans-fil grâce à l'utilisation d'ondes à très haute fréquence, de l'ordre du térahertz.

Mis au point en collaboration avec l'Université d'Osaka, le premier prototype de puce exploitant cette technologie permet déjà des débit d'1.5 Gbit/s avec une puce plus petite qu'une pièce de 10 yens (soit environ 10 centimes d'euros, donc une petite pièce...) et une antenne d'à peine 2 cm de long pour 1 cm de large. Il y a encore du chemin à faire pour arriver à 30 Gbit/s, mais le débit de 1.5 Gbit/s est déjà très supérieur à la plupart des solutions sans-fil existantes.

Mieux, le coût de production de cette puce ne serait que de quelques centaines de yens (si vous suivez bien, vous devez en déduire que ça ne fait donc que quelques euros), alors que les meilleures puces sans-fil THz actuelles coûtent plusieurs millions de yens (plusieurs dizaines de milliers d'euros), occupent 20cm² (environ une demi carte de crédit) et plafonnent à seulement 100 Mbit/s.

Rendez-vous dans trois à quatre ans pour voir ces puces entrer en production et découvrir quel est leur réel potentiel. Il faudra particulièrement surveiller la porté de leur signal, les ondes de haute fréquence n'étant pas réputées pour leur capacité à traverser les obstacles.

Posté par Matt le 24/11/2011 à 08h12

Aucun commentaire

Source : Übergizmo

![]()

Au milieu des rumeurs sur les tarifs de Free Mobile, l'AdUF vient d'en lancer une nouvelle : un forfait unique à 9€99 par mois. Si l'AdUF a bien pris la peine de préciser qu'il s'agit d'une spéculation de leur part, elle a aussi indiqué comment elle a déterminé ce montant, et c'est sur ce point que cette rumeur est intéressante.

En effet, plutôt que de lancer des dés pour déterminer des tarifs, l'AdUF a suivi un véritable raisonnement, partant de quatre déclarations des dirigeants de Free :

- un objectif de 25% de part de marché "dans deux ans si on est très bons",

- un chiffre d'affaire doublé d'ici à 2015,

- "Diviser la facture d'un foyer par deux",

- "Un prix clair, facile à retenir".

Selon l'ARCEP, la facture moyenne d'un abonné mobile est aujourd'hui de 25€10 par mois. En divisant par deux, on devrait donc arriver à une facture moyenne ne dépassant pas 12€55. Par ailleurs, doubler le chiffre d'affaires d'ici à 2015 revient à générer 2.2 milliards d'euros supplémentaires, grâce à 18 millions d'abonnés mobiles (25% des 72 millions d'abonnés prévus pour 2015), soit environ plus de 10€ par abonné. Et le prix "clair et facile à retenir" impose une offre unique, que l'AdUF positionne du coup à 9€99 par mois pour correspondre aux objectifs de chiffre d'affaire.

L'hypothèse qui est donc réalisée de façon intéressante et réaliste, mais il y a tout de même quelques petits détails qui pourraient l'invalider :

- l'objectif de 25% de part de marché "si on est très bon" est un objectif très ambitieux de la part de Free. L'objectif de chiffre d'affaire est sans doute pour sa part fixé à partir de prévisions moins optimistes, pour limiter le risque de ne pas ternir l'objectif...

- la hausse de chiffre d'affaire d'ici à 2015 ne proviendra normalement pas que des abonnements mobiles, mais aussi de la hausse du marché de l'ADSL/fibre et des rentrées d'argent liées aux terminaisons d'appels entrants vers les abonnés Free (fixe et mobile),

- Xavier Niel a rappelé il y a quelques temps que la division du prix par 2 sera par rapport à 2008, et non par rapport à 2011,

- le chiffre d'affaire se mesure hors taxes, et il faut donc ajouter la TVA, à 19.6%.

À mon tour donc de jouer au petit jeu des spéculations : compte tenu de ces éléments, je parierais sur un forfait entre 14€99 et 19€99 dans le cas d'une offre unique.

Posté par Matt le 23/11/2011 à 12h40

Aucun commentaire

Source : Freenews

Il semblerait que le débat sur les effets des antennes-relais sur la santé ne soit pas prêt de terminer... Outre la question des effets cancérigènes à long terme, qui n'a toujours pas de réponse, les résultats pouvant être totalement opposés d'une étude à l'autre, une nouvelle étude montrerait des effets directs et non permanents à court terme.

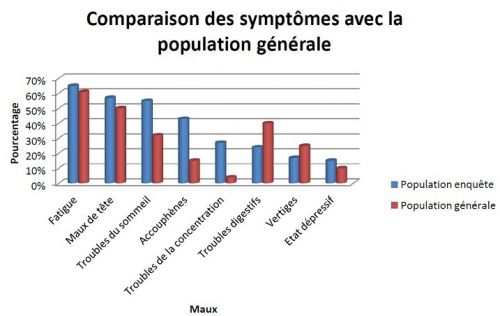

Réalisée par l'Association Santé Environnement de France, formée par environ 2500 médecins, l'étude montrerait chez les personnes vivant à proximité des antennes-relais une plus grande proportion de personnes se sentant fatiguées (+7%), ayant des maux de têtes (+10%), des troubles du sommeil (+73%), des acouphènes (+233%), des troubles de la concentration (+575%) ou encore se trouvant en état dépressif (+50%). À l'inverse, les troubles digestifs et les vertiges seraient en baisse respectivement de 45% et de 36%. Ces effets ne seraient par contre pas permanent, 83% des personnes concernées ayant indiqué la disparition des symptômes lorsqu'elles s'éloignent des antennes-relais.

L'étude a été faite via un questionnaire rempli par 143 personnes résidant dans des immeubles HLM du sud-est de la France dont les toits comportaient douze à quatorze antennes-relais. Il est donc important de noter que les réponses sont uniquement basées sur la perception des symptômes par les personnes interrogées et peuvent être affectés par un effet placebo (les personnes sachant que de nombreuses antennes sont installées sur leur toit) et par le caractère non représentatif de l'échantillon de population.

Posté par Matt le 23/11/2011 à 10h58

Aucun commentaire

Source : 01net

![]()

Les firmwares pour la Freebox Révolution continuent de se succéder. Le boîtier Player de la Freebox Révolution est désormais en 1.1.2, avec quelques corrections et nouveautés pour l'occasion.

Nouvelles fonctionnalités

- Application Dailymotion

- Application Twitter

Corrections

Télévision

- Pas de son sur la chaîne NHK

Lecteur Blu-Ray

- Son stéréo au lieu de 5.1 sur sortie SPDIF

- Scintillement des menu sur Blu-Ray 3D

Lecteur multimédia

- Écran noir lors de la lecture de vidéos

Posté par Matt le 23/11/2011 à 08h23

Aucun commentaire

Source : L'actualité de la Freebox

Depuis sa sortie il y a deux ans, Windows 7 supportent l'instruction TRIM sur les SSD, qui permet d'augmenter leur durée de vie et de réduire les pertes de performances liées à la fragmentation interne de la mémoire Flash. Cette instruction va enfin être supportée par les pilotes RAID0 Intel.

Avec les pilotes Rapid Storage Technology 11.5, il deviendra donc enfin possible de monter un RAID0 de SSD sur un chipset Intel sans perdre l'usage de la commande TRIM. Une perte qui avec le temps faisait perdre l'intérêt du RAID0, le gain de performances apporté par la parallélisation pouvant être annulé par la baisse de performances provoquée par la fragmentation.

Posté par Matt le 22/11/2011 à 14h11

Aucun commentaire

Source : TTHardware

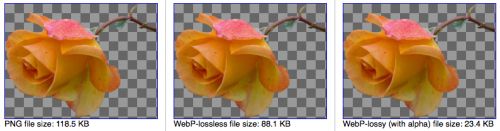

Il y a un peu plus d'un an Google avait présenté un nouveau format d'image, le WebP, basé sur le codec vidéo libre VP8 utilisé dans le format WebM. Si ce format n'a pas encore réussi à convaincre les principaux acteurs du web, Google vient de le doter d'une nouvelle arme qui pourrait faire la différence.

En effet, Google a présenté une nouvelle version du WebP apportant deux évolutions importantes : la compression sans perte et le support d'une couche alpha (utilisée pour gérer la transparence). Avec ces deux évolutions, le WebP ne vient plus seulement concurrencer le JPEG, mais vient également se frotter aux GIF et PNG, qui étaient jusqu'à présent utilisés quand il était nécessaire d'avoir de la transparence et/ou une compression sans perte.

Selon Google, le gain de poids moyen du WebP lossless par rapport au PNG serait de 45% pour un PNG classique et 28% pour un PNG optimisés avec les outils PNGCruch et PNGOut. Mais surtout, le WebP propose désormais un avantage de poids (c'est le cas de le dire :-) ) face à ses principaux concurrents car il est le seul à proposer à la fois une couche alpha et une compression avec pertes, ce qui permettra de réduire fortement le poids de toutes les images ayant besoin de transparence mais pouvant se contenter d'une compression avec pertes.

Malgré ces qualités, il faudra toutefois encore du temps avant que ce format puisse s'imposer sur le web. En effet, il ne pourra vraiment être utilisé qu'une fois que l'écrasante majorité du parc de navigateurs web le supportera. À l'heure actuelle, seuls Chrome et Opera le supportent.

Posté par Matt le 22/11/2011 à 10h50

Aucun commentaire

Source : Clubic

Il y a quelques années, quand les Partis Pirates ont commencé à apparaitre dans divers pays, ils ont fait sourire dans les rangs politiques. Jeunes et atypiques (voir ce reportage sur l'entrée des Pirates au parlement de Berlin...), les membres de ces partis ne semblaient pas forcément promus à un bel avenir politique... Et pourtant, petit à petit, ils font leur place. Un second siège au parlement européen vient d'ailleurs d'être décroché.

Depuis les élections européennes, le suédois Christian Engström était l'unique représentant du parti pirate au parlement européen , après que son parti ait obtenu 7.1% des voix en Suède, pays d'origine du mouvement Pirate. Mais grâce à l'entrée en vigueur du Traité de Lisbonne, la Suède dispose désormais de deux sièges supplémentaires (20 au lieu de 18), et il a été décidé que l'un de ces sièges revenait au Parti Pirate. C'est donc la jeune Amelia Andersdotter qui rejoint le parlement, où elle compte notamment faire entendre sa voix sur les questions de régulation des opérateurs de télécoms : "Les approches européennes au droit de la concurrence doivent changer, au moins un peu. Par une meilleure adaptation à chaque secteur, par exemple. Le manque de véritable contrôle sur l'intégration verticale crée des situations où les entreprises des télécoms (ou de média) possèdent tout, des câbles backbone aux services de streaming de musique. Ca n'est pas bon. On s'attend au moins à avoir certaines obligations pour maintenir les différentes parties séparées. Actuellement ce type de regroupement est, de façon plus préoccupante encore, encouragé plutôt que réguler, et ça crée un déséquilibre très injuste entre ceux qui possèdent l'infrastructure (dans ce cas) et les utilisateurs. Le droit de la concurrence pour l'instant s'occupe essentiellement des intégrations horizontales, où par exemple une seule société possède tous le câble dans le nord de la Belgique (Telenet)."

Du haut de ses 24 ans, elle est aussi (et probablement de loin...) la plus jeune eurodéputée. Mais elle pourra sans doute compter sur son collègue Christin Engström, 51 ans, pour lui transmettre son expérience. Son mandat se terminera avec les prochaines élections européennes, en 2014.

D'ici là, on peut s'attendre à ce que les Partis Pirates fassent une nouvelle percée électorale. En effet, outre la Suède, où il avait atteint 7.1% des suffrages en 2009, le Parti Pirate connait une popularité croissante dans d'autres pays d'Europe, et en particulier en Allemagne, il dispose déjà de deux conseillers municipaux (Münster et Aix-la-Chapelle) et de quinze représentants au parlement régional de Berlin grâce à un score de près de 9%. En France, le meilleur score Pirate est pour l'instant de 2.1% lors de législatives partielles dans les Yvelines.

Posté par Matt le 22/11/2011 à 10h30

Aucun commentaire

Source : Numérama

Dans la course à la finesse pour les tablettes et les ordinateurs ultra-portables, la question du stockage oblige souvent à un dilemme : privilégier la finesse, en optant exclusivement pour de la mémoire flash, ou privilégier la capacité, en optant pour un disque dur ? Une équipe de chercheurs travaille a une solution intermédiaire qui pourrait s'avérer intéressante.

En effet, alors que les disques durs 2.5" standard font actuellement 9.5mm d'épaisseur et que quelques rares modèles se contentent de 7mm, les chercheurs du Data Storage Institute (entité de la Singapore Agency for Science) ont réussi à mettre au point un disque dur 2.5" de moins de 5mm d'épaisseur. La plus grande difficulté a été la réalisation d'un moteur axial d'à peine 4mm d'épaisseur.

Ce gain en finesse devrait se faire sans sacrifier les performances, le moteur réalisé étant capable de monter jusqu'à 7200 tours par minute. La capacité sera par contre limitée, le châssis ne pouvant accueillir qu'un seul plateau. De quoi proposer tout de même des capacités dépassant les 500 Go, ce qui serait un gros progrès par rapport aux quelques dizaines de Go de mémoire flash embarquée dans les tablettes.

Les chercheurs travaillent également à intégrer un peu de mémoire flash à leur produit, pour en faire un disque hybride, et ainsi ne pas trop sacrifier l'autonomie des tablettes et ultra-portables auxquels il sera intégré.

Posté par Matt le 22/11/2011 à 08h30

Aucun commentaire

Source : Macbidouille

Cela faisait longtemps que les FAI n'avaient pas eu droit à une nouvelle taxe... C'est désormais chose faite, comme l'a annoncé Nicolas Sarkozy, avec une nouvelle taxe visant à subventionner le monde de la musique.

Après la taxe COSIP, déjà payée par les FAI pour financer le Centra National du Cinéma, cette nouvelle taxe sera affectée au financement du Centre National de la Musique, qui subventionnera la création musicale. Mais contrairement à la taxe COSIP, également payée par les chaînes de télévision et les opérateurs mobiles, cette nouvelle taxe devrait être l'exclusivité des FAI.

Maladroitement, Nicolas Sarkozy a justifié le fait de cibler les FAI en expliquant que les infrastructures permettant l'accès à Internet sont financées par l'État : "On a le droit de parler des droits d'auteur et d'un gros mot, qui est la fiscalité numérique, car qui paye les infrastructures qui permettent à internet de vous relier, si ce n'est l'État, donc le contribuable ?". Peut-être faudrait-il lui rappeler que les opérateurs Internet sont aujourd'hui tous des entreprises privées et qu'ils empruntent des réseaux entretenus par des entreprises privés et dont la plupart des infrastructures liées à Internet ont été financées par le privé...

Suite à l'annonce de cette nouvelle taxe, la Fédération Française des Télécoms (regroupant quasiment tous les opérateurs fixes et mobiles, à l'exception de Free et Numéricable) s'est inquiété de la multiplication des taxes touchant ses membres, taxe qui en plus ne sont pas toujours en rapport avec leur activité. Selon la fédération, l'ensemble des taxes spécifiques aux opérateurs télécoms représente aujourd'hui le quart des impôts et taxes payés par les opérateurs.

Posté par Matt le 21/11/2011 à 12h30

Aucun commentaire

Sources : PCInpact et Numérama

Comme Internet Explorer et Chrome, Firefox devait se doter d'une architecture mutli-processus, dans laquelle chaque onglet, plug-in et extension s'exécute dans un processus séparé. Si une première étape a été atteinte, avec la séparation des plug-ins, Mozilla a indiqué que l'étape suivante n'est plus une priorité.

En effet, si cette séparation complète aurait de nombreux avantages pour la stabilité et les performances du navigateur, en évitant qu'un plantage d'un onglet ne se propage à toute l'application et en facilitant la gestion des fuites mémoire, l'opération doit aller toucher au code existant très en profondeur, donc nécessite beaucoup de temps de développement. De plus, la séparation en processus multiples risque fort de rendre la plupart des extensions incompatibles.

Compte tenu de ces contraintes, Mozilla a donc décidé de se concentrer en priorité sur des évolutions dont les effets se verront plus rapidement, par exemple une optimisation du "ramasse-miettes" en charge de surveiller les allocations mémoire pour libérer les zones qui ne sont plus utilisées.

Posté par Matt le 21/11/2011 à 11h10

Aucun commentaire

Source : PCInpact

Après l'explosion des prix des disques durs en octobre suite aux inondations en Thaïlande, les tarifs se sont plus ou moins stabilisés entre 2 et 3 fois les prix d'avant la catastrophe. Les prix devraient commencer à bosser dans les semaines à venir.

En effet, alors que les usines relancent petit à petit leur production, les principaux grossistes commencent à retrouver un approvisionnement normal, et donc à revoir leurs tarifs à la baisse. Selon certains estimations, le retour à la normale des prix, qui était initialement attendu pour mi-2012 pourrait finalement avoir lui dès février, voir janvier.

Seagate, bien qu'il soit l'un des constructeur les moins affectés, à une vision beaucoup plus pessimiste. En effet, selon le CEO, le marché du disque dur ne devrait pas être revenu à la normale avant la fin de l'année prochaine. Il indique qu'aucune usine de Seagate et que très peu d'employés ont été affectés, mais qu'une bonne partie des 130 fournisseurs dont la production dépend sont encore sous 1m d'eau.

Selon DigiTimes, sur l'ensemble du quatrième trimestre, la baisse de production serait de 67 millions d'unités chez Western Digital (-36M), Seagate (-9M), Hitachi (-11M) et Toshiba (-10M) par rapport au troisième trimestre, durant lequel ces quatre constructeurs avaient livré 162 millions de disques durs, alors que la demande serait en hausse de 18 millions d'unités.

Posté par Matt le 21/11/2011 à 08h53

Aucun commentaire

Sources : PCWorld et Tom's Hardware

C'est désormais officiel, comme la rumeur l'avait prévu, Google se lance dans la vente de musique, via son service Google Music, qui perd au passage son statu de beta. Disponible pour l'instant uniquement aux États-Unis, le service dispose de quelques atouts qui pourraient l'aider à se faire sa place.

Tout d'abord, il conserve les fonctions proposées par la version beta de Google Music, à savoir la possibilité de stocker gratuitement en ligne jusqu'à 20 000 titres (sans compter ceux obtenus via Google Music) et de les écouter ensuite depuis l'application Musique d'un appareil Android (2.2 et plus) ou depuis n'importe quel navigateur web pas trop ancien. Ensuite, Google met fortement l'accent sur les titres gratuits. Depuis le lancement de la beta de Google Music, ce sont plusieurs centaines de titres que Google a proposé gratuitement à ses utilisateurs, et ce n'est pas fini. De plus, les titres gratuits devraient désormais être téléchargeables en MP3 320 kbit/s (sans DRM donc), et non plus être limités au streaming.

Le format MP3 320 kbit/s est également celui choisi pour les titres qui seront vendus via l'Android Market. Comme sur les plateformes concurrentes, ils seront pour la plupart proposés à des tarifs compris entre 0.69$ et 1.29$ à l'unité, mais aussi sous forme d'album. Pour le lancement, Google revendique un catalogue de 13 millions de titres, en provenance des principales majors (Universal, Sony, EMI) et de plus de 1000 labels indépendants. C'est moins qu'iTunes (20M) ou Amazon (17M), mais c'est un bon début, d'autant que Warner, le grand absent du catalogue, pourrait bien signer si le succès est au rendez-vous.

Outre la gratuité du stockage en ligne, ce qui pourrait vraiment faire la différence entre Google Music et ses concurrents, en lui conférant un catalogue original et exclusif, c'est l'offre Google Music Artist Hub. Sur le même modèle que pour les applications Android, les musiciens pourront s'inscrire sur Google Music Artist Hub pour 25$ et proposer ainsi leur musique en téléchargement sur le site de Google au prix de leur choix, et même gratuitement s'ils le souhaitent. En cas de vente, Google prendra 30% de commission, comme pour les applications.

Enfin, Google n'a pas négligé l'intégration avec son réseau social Google+ : les utilisateurs de Google Music pourront partager leurs achats sur Google+, permettant ainsi à leurs contacts de les écouter en entier, mais une seule fois.

Il ne reste plus qu'à attendre que le service soit officiellement disponible chez nous, ce qui pourrait ne pas être immédiat, les négociations avec les ayants droits pouvant parfois s'éterniser, surtout quand il s'agit de proposer des titres gratuits...

Posté par Matt le 18/11/2011 à 14h00

Aucun commentaire

Source : Clubic

En avril dernier, Intel présentait Many Integrated Core, un projet dédié au calcul hautes performances construit sur les cendres du projet abandonné de carte graphique x86 Larrabee. Avec Knights Corner, ce projet devient une réalité commerciale.

Comme Intel l'avait annoncé en avril, la puce contient pas moins de 50 cœurs x86 22nm, basés sur l'architecture P55C du Pentium, mais probablement largement optimisé pour doper sa puissance de calcul, puisqu'Intel annonce une puissance brute de 1 Tflops en double précision pour l'ensemble de la puce, soit 20 Gflops par cœur. Un score qui s'approche de celui d'une puce Sandy Bridge, qui atteint 32 Gflops par cœur sur les instructions AVX.

Ajouté aux cartes mères en tant que co-processeur, cette puce pourrait donner d'excellent résultats dans le milieu du HPC. Elle offre en effet des performances au niveau de celles d'une solution GPGPU, mais l'utilisation du jeu d'instruction x86 pourrait la rendre plus simple à programmer, donc à exploiter pleinement.

Posté par Matt le 18/11/2011 à 12h36

Aucun commentaire

Source : Macbidouille

Grande nouvelle pour les internautes européens : le Parlement Européen a largement adopté hier une résolution demandant à la Commission Européenne de mettre en place la régulation nécessaire pour assurer le respect strict de la neutralité du net.

Si une telle résolution n'a pas force de loi, elle a le mérite de mettre la pression sur la Commission Européenne en lui indiquant la direction que veulent suivre les élus du peuple. On peut donc espérer que cette résolution aide la commissaire européenne Neelie Kroes, fortement engagée en faveur des libertés individuelles, à faire inscrire le principe de la neutralité du net dans les lois européennes, comme elle a déjà réussi à le faire chez elle, aux Pays-Bas.

Le texte intégral de cette résolution est lisible sur Numérama.

Posté par Matt le 18/11/2011 à 10h00

Aucun commentaire

Source : Numérama

En un peu plus de 13 ans d'existence, Google a connu beaucoup de succès et s'est taillé une place de choix sur de nombreux marchés. Mais cela n'empêche pas le géant de la recherche de connaitre quelques échecs. Il semblerait que ça soit le cas du concept Chromebook...

Lancés il y a six mois, les Chromebook sont des ordinateurs portables low-cost, très proches des netbooks, dotés du système d'exploitation Chrome OS de Google, qui a la particularité de s'articuler autour du navigateur web, pour n'utiliser que des web app. Un concept qui pouvait être intéressant sur le papier, en éliminant toute problématique de maintenance logicielle, mais qui souffre tout de même de deux défauts : pour profiter pleinement d'un Chromebook, il faut une connexion Internet sans-fil permanente, souvent couteuse, et le prix de vente des machines est plutôt élevé compte tenu de leurs caractéristiques.

Résultat des courses, six mois après le lancement, les chiffres de ventes chez les deux constructeurs (Acer et Samsung) sont bas, et même ridiculement bas... Acer indique ainsi n'avoir écoulé que 5 000 exemplaires de son Cromia 761, tandis que Samsung préfère n'indiquer aucun chiffre sur ses propres ventes...

S'il veut relancer son concept, Google va donc devoir revoir sa copie. L'américain tenterait notamment de commencer par populariser Chrome OS auprès des utilisateurs, en incitant les constructeurs de PC à livrer des machines dotées de Chrome OS en double boot. Peut-être qu'une convergence avec Android serait également la bienvenue, mais elle ne semble pas être à l'ordre du jour pour l'instant.

Posté par Matt le 18/11/2011 à 08h31

Aucun commentaire

Source : Génération NT

![]()

Selon les engagements pris par Free Mobile, l'opérateur sera en droit d'ouvrir commercialement son offre dès lors qu'il aura couvert au moins 27% de la population. Si l'ARCEP devait initialement vérifier ce taux de couverture en janvier 2012, il semblerait selon les dernières informations que Free pourrait lancer son offre avant Noël.

La rumeur a commencé à enfler il y a quelques jour, en provenance des opérateurs : Free serait très proche d'avoir atteint son taux de couverture minimal, et serait donc techniquement prêt pour le lancement. Une information confirmée ce matin par Thomas Reynaud, directeur financier d'Iliad, la maison mère de Free : "Free Mobile couvre désormais plus de 30 % de la population avec son propre réseau. Notre couverture pour justifier le minima de 27 % est en cours d'audit par l'ARCEP."

Si l'audit de l'ARCEP a été avancé par rapport à la date initiale, il y a donc fort à parier que c'est parce que Free Mobile lancera son offre plus tôt que prévu. Tous les signes tendent dans ce sens, aussi bien du côté technique que du côté de la communication, les dirigeants du groupe multipliant en ce moment les commentaires à propos de Free Mobile dans des interviews. Il serait de plus surprenant que Free laisse passer la période de Noël, propice aux ventes (25% des ouvertures de lignes en France se feraient pendant cette période)... Certains évoquent la date du 19 décembre.

On devrait donc très prochainement être fixés sur les offres de Free Mobile. Selon les derniers propos de Xavier Niel, l'opérateur serait toujours en mesure de proposer quelque chose de vraiment différent, malgré l'arrivée des offres low-cost des trois autres opérateurs : "Le lancement de Free Mobile sera un jour important pour le consommateur français. ... un prix clair, facile à retenir, pour se distinguer sur un marché où personne ne sait combien il paie ... la France est le pays occidental le plus agressif sur les tarifs de l’Internet haut débit. Nous voulons qu’il le devienne aussi sur le mobile, où il est l’un des plus mauvais". Le fondateur de l'opérateur précise aussi que "le lendemain du jour où on lance Free Mobile, ça marche", sans doute pour rassurer ceux qui craignent des débuts chaotiques comme ceux de la Freebox Révolution, marqués par de nombreux retards de livraison.

Côté terminaux, on sait qu'ils ne seront pas subventionnés, mais devraient être proposés avec la possibilité d'un paiement étalé sur plusieurs mois, grâce à un partenariat entre Free Mobile et Sofinco. Un large catalogue d'appareils devrait être proposé, puisque Xavier Niel indique que "la plupart des grandes marques" seront proposées, "sauf une qui n'a pas été retenue". S'il ne précise pas qui a été rejeté, il indique que ce n'est pas Apple, puisque l'iPhone sera bien au catalogue.

Enfin, certaines rumeurs indiquent que pour se constituer au plus vite une base d'abonnés, Free Mobile envisagerait d'envoyer automatiquement une carte SIM à tous ses abonnés ADSL, les incitant ainsi à changer d'opérateur. Une opération sans précédent qui conforterait bien l'image de trublion de Free...

Posté par Matt le 17/11/2011 à 23h11

Aucun commentaire

Sources : PCInpact et Freenews

Depuis le début de l'année, et la mise en place d'un nouveau cycle de développement accélérant les sorties, Mozilla se concentre beaucoup sur l'optimisation des besoins en ressources de son navigateur. Un travail qui a déjà porté ses fruits avec les dernières versions du panda, mais qui ne suffit pas encore aux yeux de Mozilla.

L'éditeur cherche en effet désormais à faire diminuer la consommation mémoire des extensions de son navigateur. Certaines d'entre elles s'avèrent en effet parfois particulièrement gourmandes, et peuvent fortement pénaliser les performances de Firefox.

Mozilla ne pouvant intervenir directement dans le développement des extensions, ce sont trois mesures indirectes qui ont été proposées par Justin Lebar, un des développeurs de Firefox :

- les développeurs soumettant des extensions à la validation de Mozilla pour leur diffusion sur le site officiel des extensions devront s'assurer au préalable qu'elles ne souffrent pas de fuites mémoire,

- les extensions les plus gourmandes pourraient être signalées par un avertissement à l'utilisateur,

- Mozilla va travailler à la mise au point de meilleurs outils de développement pour les extensions, afin de faciliter le travail des développeurs tiers.

Posté par Matt le 17/11/2011 à 13h00

Aucun commentaire

Source : PCInpact

Depuis des années, l'autonomie des produits mobiles est un problème récurrent, d'autant plus que le temps de recharge est parfois long, voir très long. Les chercheurs de la Northwestern University (Chicago) pourraient avoir trouvé une solution résolvant les deux problèmes.

En effet, en remplaçant les habituelles anodes de graphite des batteries Lithium-Ion par des anodes constituées de feuilles de graphènes perforées de trous d'une dizaine de nanomètres et recouvertes de silicium, les chercheurs ont réussi à augmenter très fortement la surface d'échange à l'anode, permettant donc d'augmenter le débit d'électrons. Les chercheurs vont désormais travailler sur un traitement similaire à appliquer à la cathode, et envisagent d'arriver à un produit industrialisable dans trois à cinq ans.

Le procédé permettrait également d'augmenter la capacité des batteries à encombrement égal, mais au prix par contre d'une baisse plus rapide de la capacité au fil des charges : au bout de seulement 150 charges, la moitié du gain de capacité par rapport à une batterie Lithium-Ion classique serait déjà perdue.

S'ils y parviennent, cette technologie promet des batteries pouvant se recharger dix fois plus vite et offrant une capacité dix fois supérieur. De quoi donner en quinze minutes une semaine d'autonomie à un smartphone... à condition bien sûr de disposer d'un chargeur de puissance suffisante, les 2.5W de l'USB étant bien insuffisants pour ça...

Posté par Matt le 17/11/2011 à 10h21

Aucun commentaire

Source : Macbidouille

Selon le dernier rapport publié par Gartner sur les ventes de smartphones, Android équipe un smartphone sur deux vendus dans le monde au troisième trimestre 2011. C'est la première fois qu'Android dépasse les 50% au niveau mondial.

Dans un marché en hausse de 42% sur un an (115M d'unités), les ventes d'appareils Android ont explosé de 194%, pour atteindre 60.5M d'unités (52.5% du marché). Le second système le plus populaire est Symbian, avec 19.5M d'unités (16.9%), en baisse de 10M. iOS (17.3M, 15%) et RIM (12.7M, 11%) conservent leurs 3ème et 4ème places, mais avec un écart grandissant en faveur d'iOS, tandis que Bada (2.5M, 2.2%) prend la 5ème place à Windows (1.7M, 1.5%).

En France, Android a également passé une barre symbolique depuis ce trimestre : il est désormais devant iOS en part dans le parc installé. Ainsi, selon Médiamétrie, 13% des français sont équipés d'un smartphone Android, et même 18% des 25-34 ans. C'est deux fois plus qu'il y a six mois. Médiamétrie n'a par contre pas précisé la part de marché d'iOS, se contentant d'indiquer qu'Android est passé en tête.

Je profite également de cette news pour vous signaler que j'ai ouvert un blog dédié à Android. Depuis quelques temps, je trouvais que je faisais un peu trop de news sur le sujet sur Infobidouille (et encore, je me retenais ^^), et j'ai donc finalement décidé de les mettre sur un site à part, entièrement dédié à l'OS de Google et aux produits qui l'utilisent.

Posté par Matt le 17/11/2011 à 09h00

Aucun commentaire

Sources : Smartphone France

![]()

Les firmwares pour la Freebox Révolution continuent de se succéder. Le boîtier Player de la Freebox Révolution est désormais en 1.1.2, avec quelques corrections et nouveautés pour l'occasion.

Evolutions mineures

Application YouTube

- Déplacement dans la vidéo avec les flèches

- Affichage de la progression du chargement de la vidéo

Corrections

Système

- Prise en charge de l’allumage à l’aide d’un clavier

- Problèmes d’autonégociation Gigabit

- Impossible de supprimer le mot de passe AirMedia

Télévision

- Affichage transitoire de l’ancienne chaine pendant un zap

- ‘Programme inconnu’ dans le guide des programmes

Affichage

- Pertes de signal intermittentes sur TV SONY connectée en HDMI

- Pertes des couleurs intermittentes sur TV connectée en Péritel

Lecteur Blu-ray/DVD

- Affichage étiré lors de la lecture d’un DVD au format 4:3

- Ajout d´une option pour accéder au Popup-menu du disque

Lecteur multimédia

- Saccades lors de la lecture de vidéos depuis un disque branché en USB

Posté par Matt le 16/11/2011 à 14h51

Aucun commentaire

Source : L'actualité de la Freebox

Après avoir créé la surprise en début d'année en annonçant un partenariat stratégique avec Microsoft et l'abandon des OS mobiles maison, Nokia vient de lancer son premier smartphone fruit de ce partenariat, le Lumia 800 sous Windows Phone 7.5.

L'OS étant en rupture avec les produits habituels de Nokia, le finlandais a choisi un design lui aussi en rupture, en reprenant le châssis coloré à tranche arrondi du N9, qui fait un peu penser à un iPod Mini de première génération, surmonté d'un écran tactile 3.7" AMOLED dépassant de la façade. On aime ou on n'aime pas, mais on n'y reste pas indifférent.

À l'intérieur, on trouve un processeur mono-cœur à 1.4 GHz (Microsoft ne supporte toujours pas les puces multi-cœurs...), 512 Mo de RAM, 16 Go de stockage, un APN 8MP/720p avec optique autofocus Karl Zeis et double flash LED, le Wi-Fi, le Bluetooth, une puce GPS, un tuner FM et les capteurs habituels des smartphones modernes (accéléromètre, proximité, boussole...).

Il reste maintenant à voir si la stratégie de la rupture était la bonne pour Nokia, qui a de moins en moins droit à l'erreur sur un marché qu'il l'a totalement dépassé.

Posté par Matt le 16/11/2011 à 12h20

Aucun commentaire

Source : TechCrunch

Proposée depuis quelques temps par certains navigateurs, la fonction "Do Not Track", qui permet de spécifier aux sites web que l'utilisateur ne souhaite pas que ses habitudes soient tracées, pourrait bientôt être standardisée par le W3C, qui a commencé à travailler sur le sujet.

Le W3C a constitué il y a deux mois un groupe de travail sur le sujet, constitué notamment de représentants d'Apple, Microsoft, Mozilla, Opera, Google et Facebook. Le groupe a publié il y a peu un premier brouillon de ce standard, baptisé "Tracking Preference Expression". La version finale devrait être publiée dans le courant de l'année prochaine.

Une fois le standard en place, il permettra à l'utilisateur de désactiver le tracking de façon globale, et n'aura donc plus à le faire au cas par cas pour tous les sites qu'il fréquente. Le respect de ce choix de l'utilisateur par les sites web restera malheureusement du ressort de leur bonne volonté, mais le standard prévoit tout de même que les navigateurs soit dotés d'un dispositif d'alerte pour prévenir l'utilisateur lorsqu'il visite un site ne respectant pas la norme.

Posté par Matt le 16/11/2011 à 10h42

Aucun commentaire

Source : Numerama

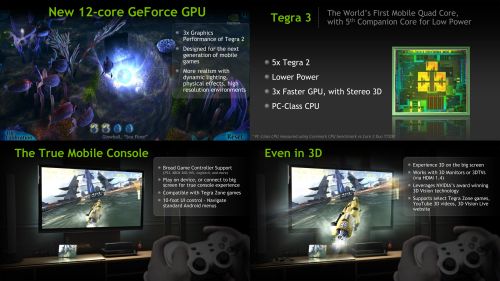

![]()

Déjà présent sur le marché des tablettes avec deux produits sous Android, la Flyer (7") et la Jetstream (10"), HTC aurait en projet une nouvelle tablette pour début 2012, qui fera un bon en avant côté performances grâce à l'adoption du SoC nVidia Tegra 3, tout en changeant de système d'exploitation, en adoptant Windows 8. Encore au stade de la rumeur, elle pourrait être officialisée en février 2012 lors du Mobile World Congress.

Posté par Matt le 16/11/2011 à 08h57

Aucun commentaire

Source : PCWorld

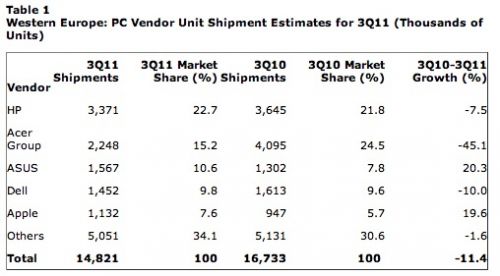

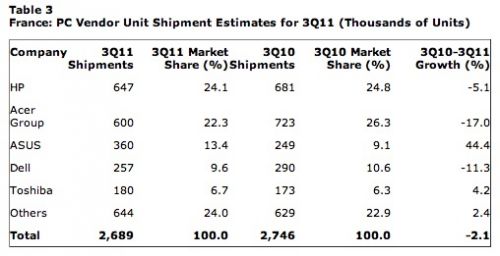

En raison de la crise économique et de la concurrence des tablettes et, dans une moindre mesure, des smartphones, les ventes d'ordinateur en Europe sont en berne, avec au troisième trimestre 2011 une baisse de 11% par rapport à 2010 selon Gartner. Deux constructeurs tirent toutefois très bien leur épingle du jeu : Asus et Apple.

Avec 1 567 000 d'unités vendues ce trimestre en Europe, Asus voit en effet ses ventes progresser de 20.3% sur un an, et sa part de marché dépasser les 10% (10.6%, en hausse de 2.8 points), ce qui lui permet de prétendre à la troisième marche du podium, derrière les indélogeables HP (redevenu premier) et Acer (tombé à la seconde place). Apple a pour sa part écoulé 1 132 000 de Mac en Europe, ce qui lui permet d'atteindre 7.6% du marché (+1.9 points), contre "seulement" 947 000 unités il y a un an, soit une hausse des ventes de 19.6%. La principale victime de la baisse des ventes est Acer, qui a perdu près de la moitié de sa clientèle (-45.1%, 2 248 000 d'unités), passant ainsi de 24.5% du marché à 10.6%.

Sur le marché français, qui n'a globalement baissé que de 2.1%, la progression d'Asus est encore plus impressionnante : de 249 000 unités (9.1%), le constructeur asiatique est passé à 360 000 unités (13.4%), soit une hausse de 44.4%, devenant, en France aussi, le troisième plus gros constructeur. Acer est aussi le plus gros perdant ce trimestre, mais avec une chute moins marquée (-17%), qui ne lui permet tout de même pas de conserver sa première place, cédée à HP. Gartner se limitant aux top 5, l'évolution des ventes d'Apple en France n'est pas connue, la cinquième place étant occupée chez nous par Toshiba, avec 6.7% du marché (contre 6.3% il y a un an). On peut donc simplement en déduire que la part d'Apple en France est inférieure à 6.7%, et donc inférieure à la part en Europe (7.6%).

Posté par Matt le 15/11/2011 à 14h20

Aucun commentaire

Source : Macbidouille

Les laboratoires de recherche et développement des grandes multinationales sont souvent des endroits très secrets. Mais il y en a parfois qui sont encore plus secrets. Ainsi, selon le New York Times, Google disposerait en Californie d'un labo secret baptisé Google X, dont l'existence même serait ignorée de la plupart des employés.

Ce laboratoire travaillerait sur une centaine de projets, touchant en partie au domaine de l'informatique (intelligence artificielle, Internet des objets...), mais pas seulement, puisque la robotique par exemple y occuperait également une part importante (il est vrai que Google a déjà démontré publiquement son intérêt pour ce domaine, par exemple avec sa voiture automatique), mais aussi d'autres technologies futures, liées par exemple à l'exploration spatiale.

Google X serait supervisé directement par Sergey Brin, un des deux fondateurs du groupe, qui a travaillé avec Larry Page, l'autre fondateur de Google. Les équipes projet sont pour leur part constitués de divers spécialistes des domaines concernés. Le New York Times indique par ailleurs qu'une partie de ces derniers auraient été débauchés chez d'autres grands noms de la R&D en informatique et électronique, notamment Microsoft et Nokia Research Labs.

Posté par Matt le 15/11/2011 à 10h20

Aucun commentaire

Source : Génération NT

Depuis quelques années déjà, la puissance de calcul individuelle des processeurs progresse beaucoup moins vite. Ce n'est pas la sortie aujourd'hui du nouveau fleuron d'Intel qui prouvera le contraire : le Core i7 3960X n'est en moyenne pas plus de 20% plus rapide que le 980X sorti il y a 18 mois... Il est loin le temps où la puissance doublait tous les deux ans, voir moins. Il semblerait que les supercalculateurs commencent eux aussi à être affectés par ce ralentissement...

En effet, alors que jusqu'à présent le tassement des performances des processeurs était compensé par une multiplication du nombre de cœurs, qui peut dépasser les 100 000 dans certaines machines (le record étant à 584 352 cœurs), cette course à la puissance connait un impressionnant coup d'arrêt au regarde de la liste Top 500 de novembre 2011, qui vient d'être publiée. S'il n'est pas surprenant que le K Computer japonais reste en tête, tant il avait creusé l'écart avec ses concurrents, les changements se font rares également dans les premières places du classement. Pour la première fois en 19 ans d'existence de ce classement bi-annuel, le Top 10 est totalement inchangé.

Bien entendu, les causes de cette stagnation ne sont probablement pas les mêmes que dans le domaine des processeurs. Si les processeurs progressent peu, c'est avant tout à cause de limites physiques qui plafonnent la puissance de traitement par cœur, et de limites logicielles qui font qu'il est peu utile de pousser au delà de quatre cœurs pour une machine individuelle. Deux limites qui concernent beaucoup moins les supercalculateurs, "habitués" à gérer des milliers de cœurs. Il y a des chances que la vraie raison de cette stagnation est plutôt ici une réduction des investissement pour des raisons économiques, ou encore une temporisation des principaux acteurs du marché le temps de réussir à construire une machine capable de surpasser le K Computer.

Posté par Matt le 15/11/2011 à 09h02

Aucun commentaire

Source : Tom's Hardware

![]()

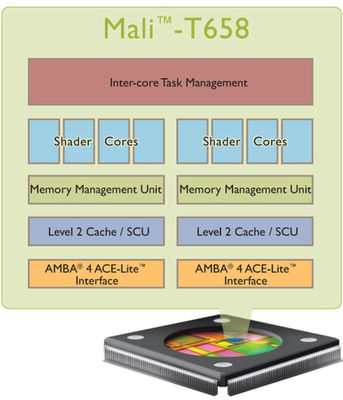

ARM a dévoilé son nouveau processeur graphique mobile haut de gamme, le Mali T658, qui promet des performances de très haut niveau. De quoi aider peut-être ARM à améliorer sa part de marché sur ce secteur, où l'anglais est encore un peu à la peine face à Imagination et ses puces PowerVR.

Dix fois plus performant que le Mali 400, actuel haut de gamme de la marque, et quatre fois plus puissant que le Mali T604, qui devrait constituer le haut de gamme ARM l'année prochaine, cette nouvelle puce embarquera un à huit cœurs, chacun doté de quatre processeurs de flux, d'un contrôleur mémoire et d'un cache L2 de 32 à 256 Ko. Destiné avant tout au graphisme via les API OpenGL ES 1.1, 2.0, OpenVG 1.1 et Direct X 11, le Mali T658 supportera aussi les API de GPGPU OpenCL 1.1, Google Renderscript et DirectX Compute.

Il ne faudra par contre pas être trop pressé de voir cette puce dans un smartphone. Selon la roadmap actuelle d'ARM, le Mali T658 n'arrivera dans les smartphones haut de gamme que fin 2013 en version quadri-cœur, et il faudra attendre mi-2015 pour goûter aux performances de la version à huit cœurs.

Posté par Matt le 14/11/2011 à 09h22

Aucun commentaire

Source : Tom's Hardware

Les jours du précieux papier rose sont comptés. Chassé par le numérique, le permis de conduire papier sera en effet très prochainement remplacé par une version électronique, comme la future carte d'identité.

Le Journal Officiel de la République Française du 10 novembre 2011 contient en effet le décret de transposition pour la directive européenne 2006/126/CE, qui vise à l'harmonisation des permis de conduire au sein des pays membres de l'Union Européenne. Outre une modification des catégories de véhicules et des critères d'accession, le permis se présentera à partir du 19 janvier 2013 sous la forme d'une carte à puce.

Permettant aux forces de l'ordre de vérifier plus facilement si le document est original, la puce permettra également en cas de contrôle de vérifier si le titulaire est à jour sur le paiement de ses amendes, et ce dans l'ensemble des pays de l'Union, ce qui limitera fortement la quasi impunité dont profitaient les conducteurs étrangers. Un site Internet dédié permettra également au titulaire disposant d'un lecteur de cartes à puces de consulter en ligne son solde de point et de procéder au paiement de ses amendes.

Autre nouveauté importante, le permis de conduire aura désormais une durée de validité. Alors qu'il était jusqu'à présent valide à vie, il faudra le renouveler tous les quinze ans. Il s'agira par contre d'une opération purement administrative, comme un renouvellement de carte d'identité, et non d'un examen à repasser.

Le permis papier tel que nous le connaissons actuellement disparaitra définitivement à partir de 2033, ce qui laissera vingt ans aux titulaires pour demander son renouvellement par une version électronique.

Finira-t-on aussi par avoir des véhicules nécessitant l'insertion d'un permis à puce pour démarrer ?

Posté par Matt le 11/11/2011 à 16h20

Aucun commentaire

Source : Tom's Guide

Lancée fin septembre par Amazon, la tablette Kindle Fire était considérée par beaucoup comme le plus sérieux concurrent de l'iPad. Une opinion que les ventes semblent confirmer pour l'instant, Amazon ayant à nouveau revu ses objectifs à la hausse.

Après avoir vendu 100 000 exemplaires de sa tablette lors de son premier jour de commercialisation, Amazon avait une première fois augmenté ses objectifs pour la fin de l'année, passant de 3.5 millions d'unités à 4 millions. Ce succès des premiers jours n'était visiblement pas passager, puisqu'un peu plus d'un mois après le lancement, Amazon vient d'augmenter une seconde fois son objectif, qui atteint désormais 5 millions d'unités.

Un succès sans doute bien aidé par le modèle économique choisi par Amazon : la tablette est vendue à très bas prix, peut-être même à pertes selon certaines sources, Amazon comptant ensuite sur la vente de contenus (applications, musiques, films, livres...) pour faire sa marge. Ainsi, la Kindle Fire se retrouve à seulement 199$ aux États-Unis, soit à peine 40% du premier prix de l'iPad 2.

Posté par Matt le 11/11/2011 à 14h21

Aucun commentaire

Source : Numérama

La socialiste Françoise Casteix, eurodéputée du Sud-Ouest de la France a déposé auprès de la Commission Européenne une question prioritaire sur la légalité de Facebook au regard du droit européen sur la conservation des données personnelles.

Expliquant que "Facebook conserve sur le long terme les données de ses utilisateurs sans que ces derniers ne puissent donner leur consentement explicite à cette utilisation de leurs données, contrairement à ce que prévoit la directive européenne sur la protection de la vie privée", la députée demande à la Commission de vérifier si Facebook respecte la législation européenne sur la conservation de données personnelles.

Il semblerait au moins que Facebook ne respecte pas la réglementation française sur ce point. En effet, la loi prévoit que la durée de conservation des données personnelles soit limitée dans le temps à une durée "qui n'excède pas celle nécessaire aux finalités pour lesquelles elles sont collectées et traitées". Le non-respect de cette disposition peut mener à 5 ans de prison et 300 000 euros d'amende.

La Commission Européenne a maintenant un délai de trois semaines pour répondre à la question.

Posté par Matt le 11/11/2011 à 12h41

Aucun commentaire

Source : Clubic

Dans les nombreuses batailles judiciaires qui l'opposent à Samsung, Apple vient de subir deux nouveaux revers mineurs, des juges ayant décidé de donner suite à certaines demandes d'informations de Samsung. Des demandes portant sur des informations qu'Apple ne voulait bien entendu pas divulguer...

La première demande concerne la plainte d'Apple contre Samsung en Australie pour l'interdiction de la Galaxy Tab 10.1. Si la tablette Samsung est effectivement déjà interdite à titre préliminaire, l'affaire est toujours en cours d'instruction. Samsung y a choisi une stratégie basée sur la contre-attaque, en accusant Apple de pratiques déloyales : selon Samsung, Apple obligerait les trois opérateurs australiens à pratiquer un subventionnement plus élevé sur les iPhone, les avantageant ainsi artificiellement sur le marché. À la demande de Samsung, Apple va donc devoir dévoiler les contrats passés avec les opérateurs, afin de vérifier si les soupçons de Samsung sont valides.

Pendant ce temps là, du côté de la Californie, où Samsung a attaqué Apple pour la violation de certains de ses brevets relatives à la 3G, le Coréen a obtenu l'accès à des informations encore plus sensibles : 220 pages du code source du firmware de l'iPhone 4S, probablement essentiellement issus de la partie baseband. Ceci permettra à Samsung d'analyser le code en détail pour déterminer si ou ou non il viole certains de ses brevets. Si Apple a bien communiqué ces informations, Samsung se plaint déjà de l'absence du code d'un fichier essentiel...

Rendez-vous dans quelques jours pour les prochains épisodes...

Posté par Matt le 10/11/2011 à 14h00

Aucun commentaire

![]()

Pour la télécommande de sa Freebox Révolution, Free a fait le choix peu commun d'une transmission radio plutôt qu'infrarouge. Souvent plus pratique, car s'affranchissant de presque tous les obstacles, ce choix rend par contre la Freebox incompatible avec les télécommandes universelles infrarouge. Suite à de nombreuses demandes, Free va prochainement proposer une solution.

Elle prendra la forme d'un simple dongle USB infrarouge en vente sur la boutique d'accessoires de Free. Free a précisé qu'il s'agit du récepteur IR-605Q d'AIM, qu'on peut trouver relativement facilement dans le commerce. La version actuelle du firmware le supporte d'ailleurs déjà ce dongle, ce qui permettra aux plus pressés de s'équiper immédiatement, sans attendre que Free lance la commercialisation.

Posté par Matt le 10/11/2011 à 11h37

Aucun commentaire

Source : Génération NT

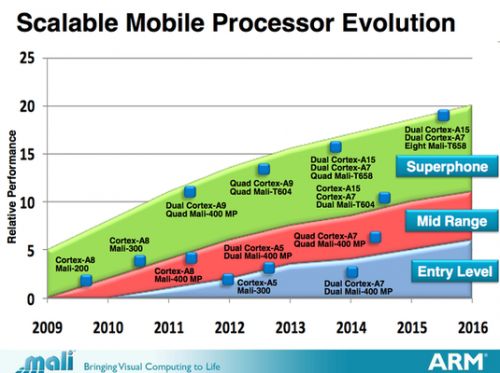

Annoncé depuis un bon bout de temps, le nouveau SoC Tegra 3 (Kal-El) d'nVidia est enfin lancé officiellement. nVidia en a profité pour dévoiler les derniers détails sur sa nouvelle plateforme mobile.

Comme nVidia l'avait déjà évoqué, Tegra 3 adopte une architecture multi-cœur hétérogène, avec quatre cœurs optimisés pour la performance et un cœurs optimisé pour la faible consommation. Lorsque la puissance nécessaire est faible (lecture vidéo, musique, veille), seul ce cinquième cœur sera activé, à une fréquence pouvant varier entre 0 et 500 MHz. En cas de besoins plus importants, c'est un, deux ou quatre cœurs hautes performances qui seront activés. Ces cœurs moduleront leur fréquence de fonctionnement entre 0 et 1.3 GHz, et même 1.4 GHz quand un seul est activé.

Grâce à cette architecture atypique, nVidia promet une consommation 15 à 60% inférieure à celle de son ancien SoC Tegra 2 et des performances jusqu'à quatre fois plus élevées que celles des SoC haut de gamme concurrents en Javascript. Les performances des contrôleurs de stockage seraient également fortement en hausse, avec le support de normes deux à six fois plus rapides que celles implémentées dans le Tegra 2 : S-ATA 3 Gbit/s, SD 3.0, eMMC 4.41...

La partie graphique ne devrait pas être en reste. Alors que le Tegra 2 avait un peu déçu sur ce point, le Tegra 3 embarque une GeForce à douze cœurs, annoncé comme trois fois plus performante que celle du Tegra 2, tout en consommant moins. La partie graphique est capable de gérer une sortie HDMI 1.4 pour jouer sur grand écran, y compris en 3D, sur les écrans supportant la technologie 3D Vision d'nVidia. Côté vidéo, le 1080p High Profile, grand absent du Tegra 2, est enfin supporté, jusqu'à un débit de 40 Mbit/s (la plupart des films Blu-Ray ne dépassant pas les 30 Mbit/s en moyenne).

Le premier produit intégrant Tegra 3 sera la nouvelle tablette Eee Pad Transformer Prime d'Asus, annoncée en même temps que le Tegra 3, qui sera disponible d'ici quelques semaines à partir de 600€.

Posté par Matt le 10/11/2011 à 09h22

Aucun commentaire

Source : PCInpact

Adobe a créé la surprise aujourd'hui, en annonçant une nouvelle qui risque d'en décevoir plus d'un : l'éditeur américain abandonne toutes les versions mobiles de son lecteur Flash. Flash était jusqu'à présent disponible sur Android et PlayBook.

Les versions existantes continueront à être maintenues pour corriger les failles de sécurité et les bugs connus, mais ça n'ira pas plus loin. En remplacement de Flash, Adobe va proposer des outils de développement se recentrant sur le HTML 5 (Dreamweaver et Edge) et sur la plateforme d'applications natives Adobe AIR. Cette mesure s'accompagne du licenciement d'environ 750 postes chez Adobe aux États-Unis et en Europe (environ 7% de l'effectif total de l'éditeur).

Nul doute que l'absence de support de Flash sur iOS a lourdement pesé sur cette décision. En effet, iOS représente toujours une part largement majoritaire du surf mobile, obligeant donc les développeurs à se tourner vers d'autres technologies que le Flash s'ils ne veulent pas perdre la majeure partie de leur audience.

Posté par Matt le 09/11/2011 à 19h54

Aucun commentaire

Source : Tom's Guide

Depuis plusieurs années, Google publie régulièrement son Transparency Report, dans lequel il indique pour chaque pays le nombre de requêtes de suppression de contenu ou de renseignements sur des utilisateurs qu'il a reçu de la part des autorités.

Dans le classement par nombre de demandes de renseignements, la France est "bien" placée, puisqu'elle est sur la première moitié de l'année 2011 le troisième pays le plus demandeur, avec 1300 requêtes (en hausse de 28% sur un an) concernant 1622 utilisateurs, derrière l'Inde (1739/2439) et les États-Unis (5950/11 057). Google avait répondu favorablement à 48% de ces demandes, ce qui laisse entendre que beaucoup n'étaient pas légitimes...

S'interrogeant sur les raisons de toutes ces demandes, le débuté Hervé Féron (Parti Socialiste) s'est adressé au ministre de l'Intérieur pour réclamer plus de transparence sur le sujet. Il demande à savoir "qui est habilité à faire de telles demandes à Google, quelles raisons justifient une demande d'informations privées, comment l'entreprise envoie-t-elle ces informations aux autorités françaises, sous quelle forme et à quel prix". Bien entendu, il souhaite aussi savoir quel est l'usage qui est ensuite fait des données obtenues en cas de réponse favorable, ainsi que la durée pendant laquelle les données sont conservées.

Officiellement, Google indique ne communiquer des renseignements sur un utilisateur que dans le cadre d'enquêtes criminelles. Il y a donc effectivement de quoi se demander à quels cas correspondent les 52% de demandes restées sans réponse...

Posté par Matt le 09/11/2011 à 14h10

Aucun commentaire

Source : Clubic

Canal+ vient de lancer CanalPlay Infinity en exclusivité pour les abonnés Internet de SFR. Ce nouveau service de vidéo à la demande fera le bonheur des boulimiques de cinéma : pour 9€99 par mois, CanalPlay Infinity donne accès en illimité à un catalogue de milliers de films et de centaines de séries.

Que ceux qui ne sont pas abonnés SFR se rassurent, cette exclusivité ne sera que de courtes durées. L'offre de Canal+ devrait en effet également être accessibles sur les Freebox avant la fin de l'année, puis sera déployé chez d'autres opérateurs. Elle sera également disponible indépendament du fournisseurs d'accès via la Xbox 360 et certains téléviseurs Samsung Smart TV.

Des offres de VOD illimitée concurrentes devraient également être lancées dans les prochaines mois, notamment chez Allociné.

Posté par Matt le 09/11/2011 à 11h51

Aucun commentaire

Source : Univers Freebox

Depuis l'abandon des tablettes et smartphones HP sous WebOS, l'avenir du système d'exploitation mobile est en suspens. Après des rumeurs sur sa réutilisation dans d'autres produits HP, dont les ordinateurs et les imprimantes, la rumeur la plus crédible semble finalement être celle de la revente.

Parmi les noms évoqués pour le rachat, Amazon, Intel, RIM et Oracle. Pour le premier, il s'agirait sans doute de mettre en place un écosystème WebOS en utilisant ce système dans ses futures tablettes, en lieu et place de la version "customisée" d'Android actuellement utilisée. En ayant son propre OS, Amazon pourrait faire évoluer celui-ci dans la direction souhaitée, sans être soumis aux choix d'entreprises concurrentes.

Pour Intel, on peut supposer que le but est de proposer une plateforme complète pour accompagner ses processeurs x86 pour smartphones et tablettes, qui peinent à trouver preneur. Intel avait déjà tenté sa chance, sans succès, avec le système MeeGo, abandonné après la défection de Nokia, et s'est récemment associé avec Samsung pour le développement d'un nouvel OS mobile dérivé de Linux, Tizen. L'hypothèse WebOS pour Intel est donc assez peu probable. Samsung avait d'ailleurs aussi un temps été évoqué pour la reprise de WebOS, avant l'annonce de l'implication du coréen dans Tizen.

L'hypothèse RIM a également de quoi laisser perplexe... Certes, le canadien a besoin de se renouveler, pour relancer ses ventes de smartphones : le BlackBerry est en chute libre, et l'avenir de RIM commence même à être menacé... Mais on peut se demander pourquoi RIM irait racheter WebOS alors qu'il vient de lancer avec sa tablette PlayBook un nouvel OS mobile, dérivé de QNX, qui devrait prochainement être adapté aux smartphones. À la limite, si WebOS avait une base d'utilisateurs conséquentes... Mais ce n'est pas le cas.

Reste enfin le cas Oracle. Il s'agit probablement là de l'hypothèse la plus inquiétante. En effet, pour Oracle, le but d'un tel rachat ne serait pas de se positionner sur le marché des OS mobiles, mais simplement de récupérer les portefeuille de brevets qui va avec WebOS. Le géant de la base de données pourrait ainsi renforcer son dossier contre Google et Android, pour tenter d'obtenir un maximum de dédommagement... Heureusement, Oracle et HP ne seraient actuellement pas en très bons termes, ce qui pourrait bloquer une telle opération.

Posté par Matt le 09/11/2011 à 09h50

Aucun commentaire

Sources : TTHardware et Numérama

Lorsque Google+ a été lancé, Google avait annoncé qu'il serait réservé aux personnes physiques inscrites sous leur véritable identité. Un choix qui avait fait râler côté grand public, certains préférant garder un minimum d'anonymat, mais aussi du côté des entreprises, déçues d'être ainsi écartées par le réseau... Elles y auront désormais leur place grâce aux Pages, comme sur Facebook.