Actualités du mois de décembre 2011

Après des mois de beta test, OVH vient de lancer officiellement HubiC (Hub in the Cloud) son offre de stockage en ligne. Face à des concurrents déjà bien installés sur le marché, comme Dropbox ou Box.net, OVH compte se distinguer par le tarif de son offre, particulièrement agressif.

L'hébergeur français propose en effet trois paliers tarifaires, tous bien plus avantageux que ceux proposés par exemple par Dropbox :

- un espace de 25 Go gratuit,

- un espace de 100 Go pour 10€ HT/an,

- un espace illimité pour 70€ HT/an.

À titre de comparaison, l'offre gratuite de Dropbox ne propose que 2 Go et les 100 Go sont facturés 20$/mois, tandis que Box.net propose 5 Go gratuitement, mais facture 50 Go 20$/mois. Même Google est aujourd'hui plus cher, avec une offre à 20$/an pour 80 Go.

Basée sur le protocole WebDAV, l'offre d'OVH est toutefois techniquement moins avancée que celle de ses concurrents. Le client HubiC sur PC ne permet par exemple pas de cloner localement le stockage en ligne, ce qui limite les performances lors de l'accès aux fichiers. Les clients mobiles, proposés pour l'instant pour Android et iOS sont également plus restreints, puisqu'ils ne permettent que la consultation et la suppression de fichiers, mais pas leur envoi.

Le service d'OVH interdit par ailleurs le partage public des données stockées, mais permettra par contre un partage privé, avec un cercle restreint de contacts, avec la possibilité de laisser un accès en lecture seule ou d'autoriser également l'écriture. Plus tard, OVH promet d'enrichir le service, en apportant des fonctionnalités de synchronisation de documents et même de lecture de médias en streaming. De quoi devenir un sérieux concurrent à Dropbox, voir Google Music ?

Posté par Matt le 29/12/2011 à 16h00

Aucun commentaire

Source : PCInpact

Si Intel a l'intention de venir s'attaquer à l'architecture ARM sur le secteur de la mobilité, le fondeur fourbit également ses armes pour se défendre contre les assauts d'ARM sur le marché des serveurs, où l'efficacité énergétique et la petite taille des SoC ARM attire de plus en plus, en particulier pour les serveurs destinés au cloud computing.

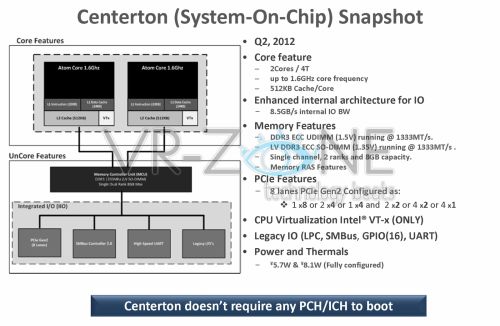

Baptisé Centerton, la nouvelle arme d'Intel sur le marché des serveurs est un SoC à base de processeur Atom. Il embarque en effet deux cœurs Atom à 1.6 GHz, dotés chacun de 512 Ko de cache et supportant l'HyperThreading et la virtualisation, un contrôleur mémoire DDR3 simple canal avec support ECC et un contrôleur PCI-Express 2.0 à 8 voies. Gravée en 32nm, cette solution devrait être commercialisée au second trimestre 2012.

Grâce à sa petite taille et sa faible consommation (5.7 à 8.1W), Intel indique qu'une armoire serveur pourra accueillir jusqu'à 2000 de ces puces, soit un total de 4000 cœurs/8000 threads par armoire. ARM pourra peut-être faire un peu mieux sur ce point, grâce à une consommation encore plus réduite, mais Intel conserve l'avantage de la compatibilité avec les logiciels existants, et précise que le passage à une gravure de 22nm est déjà prévu, ce qui devrait réduire encore un peu la consommation.

Posté par Matt le 28/12/2011 à 13h55

Aucun commentaire

Source : Clubic

Rares sont aujourd'hui les offres d'accès Internet "illimitées" qui ne comportent pas un certain nombres de clauses limitatives, restreignant le volume de données transmissible, les débits, les protocoles autorisés, voir tout à la fois. Une situation qui pourrait changer à l'avenir si les députés se rangent à l'avis des sénateurs...

Un projet de loi est en effet actuellement en cours d'élaboration, avec notamment des articles visant à encadrer l'usage du terme "illimité" pour les offres de télécommunications, et en particulier les accès Internet. Après avoir été largement édulcoré par les députés de l'Assemblé Nationale (majorité de droite) en première lecture en septembre dernier, le texte voté hier par le Sénat (majorité de gauche). Ainsi, alors que les députés validaient le principe d'une offre "illimitée" limitée, tant que les clauses limitatives sont précises et mentionnées à côté du terme "illimité", les sénateurs demandent l'interdiction de l'emploi du terme illimité dès lors que l'offre comporte des clauses prévoyant "une coupure temporaire, une facturation supplémentaire des services ou une dégradation excessive de débits ou de la qualité de service". Le principe du "fair use", largement répandu dans les offres Internet "illimitées" mobiles devient ainsi proscrit : il faudra cesser de qualifier ces offres d'"illimitées", ou ne plus appliquer la restriction de débit après un certain volume.

Les sénateurs autorisent toutefois la conservation de certaines clauses limitatives, lorsqu'elles ont pour but de protéger les opérateurs de certains abus, comme par exemple le partage (ou la revente) de l'abonnement avec d'autres personnes. Ainsi, des clauses limitant le nombre de correspondants par mois dans le cadre d'une offre de téléphonie illimitée restent admises. Enfin, la notion d'"Internet illimité" ne pourra plus être mise en avant lorsque certains protocoles ou ports sont bloqués par l'opérateur. Un premier pas en avant vers la neutralité.

Le texte voté par les sénateurs étant différent de celui voté en septembre par les députés, ce nouveau texte devra toutefois passer en seconde lecture devant l'Assemblée Nationale avant de pouvoir éventuellement être inscrit dans la loi française, et il n'est pas impossible que les députés modifient à nouveau ces amendements...

Posté par Matt le 28/12/2011 à 11h19

4 commentaires

Source : Freenews

Lors de la mise en vente des lots de fréquences dans la bande de 800 MHz pour l'exploitation de réseaux mobiles 4G LTE, les opérateurs étaient conscients d'un fort risque d'interférence avec les émission TNT, et s'étaient engagés à investir les sommes nécessaires à assurer le bon fonctionnement de toutes les transmissions. Vu les résultats des premières expérimentations, ils pourraient toutefois avoir à payer bien plus que prévu...

Menées notamment à Laval durant l'automne, ces expérimentations, effectuées en collaboration avec les opérateurs, ont en effet mis en évidence des perturbations "plus importantes que prévues", et impactant tous les canaux de la TNT, pas seulement ceux situés dans les plus hautes fréquences. Pire, les ajustements effectués pendant ces expérimentations pour tenter de remédier au problème se sont révélés insuffisants, et il n'a pas été possible de pousser l'expérimentation jusqu'au bout, en activant les huit émetteurs LTE qui devaient normalement être utilisés.

D'après les résultats de ces expérimentations, il se pourrait que les opérateur soient obligés d'aller intervenir directement sur les installations TNT des utilisateurs pour résoudre les problèmes, en y installant des filtres suffisamment sensibles pour éliminer tous les parasites. Le coût pourrait dépasser la centaine d'euros par installation à mettre en conformité.

Au regard de ses résultats, on peut se demander si Free n'aurait pas finalement fait LA bonne affaire en n'obtenant aucun bloc de la bande 800 MHz. En n'exploitant la 4G que sur la bande 2.6 GHz, l'opérateur estime en effet être en mesure de couvrir 80% de la population, ce qui limitera le coût du roaming 800 MHz, tout en n'ayant pas à payer pour résoudre les problèmes d'interférence avec la TNT (même si ce coût sera probablement en partie répercuté sur le montant des accords de roaming). Dans une moindre mesure, Bouygues aussi réalise une bonne opération. L'opérateur a en effet payé son bloc de 10 MHz nettement moins cher qu'Orange et SFR, car ce bloc était présumé être le plus problématique. D'après ces expérimentations, les autres blocs sont autant affectés, et donc, en plus d'avoir coûté plus cher à l'achat, seront aussi coûteux en mise aux normes des installations TNT.

Posté par Matt le 28/12/2011 à 09h19

Aucun commentaire

Source : Tom's Hardware

Depuis de nombreuses années, Google est le plus gros contributeur aux revenus de Mozilla, dont il représente plus de 80% du chiffre d'affaire. Depuis que Google s'est lancé sur le marché des navigateurs, beaucoup craignaient que le contrat, expirant en novembre dernier, ne soit pas renouvelé. Qu'on se rassure, Google a signé un nouveau contrat.

Google et Mozilla ont en effet publié mardi un communiqué de presse annonçant qu'un nouvel accord a été trouvé entre les deux entités. Comme le contrat précédent, il court pour une durée de trois ans, pendant laquelle Google sera configuré comme moteur de recherche par défaut à l'installation de Firefox, en échange d'espèces sonnantes et trébuchantes.

En 2010, l'accord avec Google représentait 103 millions de dollars sur les 123 millions encaissés par Mozilla. Mozilla et Google n'ont pas communiqué sur les montants en jeu dans ce nouveau contrat, et il faudra donc probablement attendre le rapport d'activité 2012 de la fondation pour connaitre le montant exact négocié.

Mozilla est donc désormais tranquille pour 3 ans, avant de devoir à nouveau négocier à Google. Une négociation qui risque de devenir plus compliquée si Chrome continue de grappiller des parts de marché.

Mise à jour le 27/12/2011 : Si Mozilla et Google ont refusé de communiquer le montant de l'accord, certaines sources évoquent un montant très en faveur de Mozilla, qui aurait réussi à convaincre Google de signer pour 300 millions de dollars par an, soit trois fois plus que dans le précédent accord, en le menaçant d'aller voir du côté de Yahoo! et de Bing (rappelons d'ailleurs qu'une version de Firefox avec Bing comme moteur de recherche par défaut est diffusée depuis quelques temps par Microsoft). Si ce montant se confirme, la fondation Mozilla va donc pouvoir se lancer sereinement dans ses projets les plus ambitieux, avec un budget en très nette hausse.

Actu originale : 22/12/2011 à 11h20

Posté par Matt le 27/12/2011 à 18h00

Aucun commentaire

Sources : Silicon.fr et PCInpact

![]()

L'ARCEP a dévoilé hier soir les résultats de la procédure d'attribution des licences 4G dans la bande des 800 MHz. Une procédure à laquelle avaient répondu les quatre opérateurs mobiles 3G, mais à l'issue de laquelle seuls les anciens opérateurs de la 2G ont obtenu des fréquences.

Il y avait pourtant bien quatre lots en vente, deux de 10 MHz et deux de 5 MHz, mais la procédure prévoyait qu'un opérateur puisse obtenir plusieurs lots. C'est chose faite pour SFR, qui a obtenu les deux lots de 5 MHz, en ayant mis 1 065 millions d'euros sur la table. C'est l'opérateur qui a misé le plus, après avoir fait des économies en mettant le strict minimum sur l'enchère des fréquences de la bande 2.6 GHz. Les deux blocs de 10 MHz ont pour leur part été attribués à Bouygues Telecom (683 millions d'euros) et Orange (891 millions d'euros).

Les trois opérateurs se sont par ailleurs engagés à accueillir des MVNO sur leur réseau et à atteindre une couverture de 99.6% de la population totale du pays, avec une couverture d'au moins 95% dans chaque département. Ils devront également mettre particulièrement l'accent sur le déploiement dans les zones moins denses, souvent oubliées par la technologie.

Free Mobile n'a pas été retenu pour une licence 800 MHz, son offre étant trop basse par rapport à celle de ses concurrents. La procédure prévoyait toutefois que les opérateurs obtenant deux lots aient l'obligation d'accueillir en itinérance les opérateurs n'ayant obtenu aucun lot, dès lors que ces opérateurs couvriront 25% du territoire avec leur réseau 2.6 GHz. Free Mobile pourra donc rapidement bénéficier de l'itinérance avec SFR.

Au final, en cumulant les deux plages de fréquence, les attributions sont les suivantes :

- Bouygues Telecom : 25 MHz (3x5 MHz en 2.6 GHz, 1x10 MHz en 800 MHz) pour un montant total de 911 millions d'euros,

- Free Mobile : 20 MHz (4x5 MHz en 2.6 GHz) pour un montant total de 271 millions d'euros,

- Orange : 30 MHz (4x5 MHz en 2.6 GHz, 1x10 MHz en 800 MHz) pour un montant total de 1 178 millions d'euros,

- SFR : 25 MHz (3x5 MHz en 2.6 GHz, 2x5 MHz en 800 MHz) pour un montant total de 1 215 millions d'euros.

Le total atteint 3 575 millions d'euros, soit 1 075 de plus que ce que l'État espérait récupérer.

C'est donc SFR qui s'en sort le moins bien d'un point de vue financier, mais l'opérateur bénéficiera de l'itinérance de Free Mobile, qui ne sera pas accordée gratuitement. Free Mobile est pour sa part celui qui paie le moins cher, tout en bénéficiant tout de même d'une plage de 20 MHz. Il s'en sort donc très bien, mais risque d'être mis en difficulté par le coût de l'itinérance. Il y a fort à parier que l'opérateur privilégiera donc la couverture des zones denses avec son réseau 2.6 GHz, malgré la mauvaise pénétration de ces ondes dans les bâtiments, pour minimiser le recours à l'itinérance.

Posté par Matt le 23/12/2011 à 08h50

4 commentaires

Source : Univers Freebox

Après avoir été maintes et maintes fois repoussés, les premiers smartphones à base de processeurs x86 pourraient arriver sur le marché en juin prochain. Intel a fait la démonstration d'un premier modèle de référence.

Embarquant une puce Atom Medfield, ce modèle de référence est le premier à avoir des dimensions "normales" pour un smartphone d'aujourd'hui, les précédents prototypes étant pour leur part des briques bien épaisses et bien larges...

Intel n'a donné que très peu d'informations sur l'appareil, mais selon le MIT Technology Review, l'appareil serait capable de faire tourner correctement Android 4.0 (Ice Cream Sandwich), de lire de la vidéo HD, et permettrait un surf parfaitement fluide. Intel a également réalisé un design de référence qui, selon les premiers témoignages, est plus léger qu'un iPad, tout en étant aussi fin et doté d'un écran plus grand. À l'usage, cette tablette de référence sous Android 4 serait plus performante que les actuelles tablettes à puce ARM sous Android 3.x (Honeycomb).

Mais pour s'imposer sur ce marché, les performances ne font pas tout : la consommation est également particulièrement importante. Sur ce point, Stephen Smith (vice-président d'Intel) affirme que la plateforme Intel bat une plateforme ARM faisant partie du "top 3", mais sans donner plus de précision.

Il faudra aussi que la plateforme Intel soit compétitive sur le plan tarifaire, ce qui n'est malheureusement que rarement le cas chez Intel...

Posté par Matt le 22/12/2011 à 12h20

Aucun commentaire

Source : Übergizmo

Il y a un an et demi, Anobit avait fait parler d'elle, en annonçant sa technologie Memory Signal Processing, qui permet de multiplier par cinq l'endurance des cellules mémoire MLC. Plutôt discrète depuis, la société fait aujourd'hui de nouveau parler d'elle, en se faisant racheter par Apple.

Apple étant devenue une très grosse consommatrice de flash depuis qu'elle en met de grandes quantités dans quasiment tous ses produits, il n'est pas surprenant qu'Apple s'intéresse de près aux technologies permettant d'améliorer l'endurance de ces mémoires.

Les technologies développées par Anobit pourraient en effet permettre à Apple de substantielles économies, en lui permettant d'utiliser de la mémoire MLC 3BPC au lieu de la classique 2BPC, sans perdre en durée de vie. Une telle évolution se traduirait pas une réduction de 33% du coût en mémoire flash pour Apple.

Ce rachat donne aussi un avantage énorme à Apple sur ses concurrents : ils devront probablement payer cher pour accéder à ces technologies dans leurs produits... Et à condition qu'Apple veuille bien les licencier, ce qui est loin d'être certain vu le passif de la pomme en matière de protection de ses brevets.

Le montant du rachat n'a pas été communiqué pour l'instant, mais les rumeurs évoquent une facture comprise entre 400 et 500 millions de dollars, ce qui en fait le plus gros rachat d'Apple depuis 1996, lorsqu'elle avait racheté NeXT à Steve Jobs pour 404 millions de dollars et en reprendre les concepts et les frameworks pour créer Mac OS X.

Posté par Matt le 22/12/2011 à 08h50

2 commentaires

Source : Tom's Hardware

La question du droit d'auteur et de sa quasi inévitable réforme sera un des points clés des programmes pour l'élection présidentielle de 2012. Pour traiter ce point dans son programme, Europe Écologie-Les Verts est allé piocher dans les idées de Richard Stallman.

Afin de "promouvoir le logiciel libre" et "un modèle qui permet le partage", Eva Joly est en effet allée s'inspirer de l'idée de Mécénat Global prônée notamment par Richard Stallman. Il s'agit en fait d'une version améliorée du concept de la licence globale. Le Mécénat Global repose sur le principe du paiement d'un montant forfaitaire obligatoire, qui donnerait le droit d'accéder aux œuvres, comme une licence globale. Mais plutôt que de traiter l'intégralité des sommes ainsi collectées en gestion collective, redistribuée sur la base de la popularité des œuvres, seuls deux tiers des sommes perçues seraient mises en gestion collective. Pour le dernier tiers, chaque internaute pourra choisir à quels artistes il souhaite l'attribuer.

Si les positions de Stallman sont parfois un peu trop extrémistes, il faut reconnaitre que l'idée du Mécénat Global est plutôt séduisante, et il est intéressant que des partis politiques de premier plan commencent à s'en inspirer. Espérons que l'intérêt des verts pour cette idée trouvera un écho dans d'autres formations politiques, les verts n'étant pas là pour jouer la gagne lors de la présidentielle.

Posté par Matt le 20/12/2011 à 10h50

1 commentaire

Source : Numérama

Cela fait quelques années que la rumeur d'une TV Apple refait régulièrement surface. C'est au tour du Wall Street Journal de l'évoquer, sur la base de certaines informations qui laisseraient entendre que le projet est plutôt bien avancé.

Selon le WSJ, Apple serait ainsi en contact avec les principaux acteurs du monde de l'audiovisuel, et en particulier les majors, pour discuter avec eux de sa vision du futur de la TV. Le projet serait visiblement de haute importance pour Apple, dont les "gradés" participent à ces discussion, comme par exemple Eddy Cue, l'un des vice présidents de la firme.

Les projets de la pomme comporteraient de "nouvelles" interfaces de commandes, basées sur la voix et les gestes (qui a dit Kinect ?) et la TV Apple serait conçue pour s'intégrer dans l'éco-système iOS, permettant par exemple de commencer la lecture d'un média sur un appareil, puis de la reprendre sur un autre appareil là où elle s'était arrêtée.

Posté par Matt le 20/12/2011 à 08h10

Aucun commentaire

Source : Mac4Ever

Alors qu'AMD doit dévoiler dans quelques jours sa nouvelle gamme de cartes graphiques, les Radeon HD 7000, les caractéristiques du futur haut de gamme ont déjà fait leur apparition sur Internet. Et elles sont plutôt alléchantes...

Avec un GPU doté de 2048 processeurs de flux cadencés à 925 MHz (overclockable à plus d'1 GHz avec le ventirad de référence), la Radeon HD 7970 développera une puissance de calcul de 3.5 TFLOPS. Ils seront assistés par 128 unités de texturing et 32 ROPs. La carte sera dotée de 3 Go de GDDR5 à 5500 MHz adressée via un bus 384 bits. Elle proposera quatre sorties vidéo : une DVI, deux mini-DisplayPort et une HDMI.

Côté consommation, comme toutes les cartes haut de gamme de ces dernières années, la Radeon HD 7970 sera très gourmande en charge, avec une consommation qui pourra friser les 300W. Bonne nouvelle par contre pour la consommation au repos, qu'AMD a particulièrement soignée : le constructeur promet moins de 3W pour la carte complète au repos, ce qui devrait même permettre d'arrêter la ventilation.

Posté par Matt le 19/12/2011 à 14h38

Aucun commentaire

Source : PCWorld

En lançant sa tablette Kindle Fire, Amazon n'avait pas caché son ambition de devenir au moins le numéro deux mondiale sur le marché des tablettes. Au vu des dernières annonces du géant de la VPC, l'objectif semble atteint.

Même s'il n'a pas communiqué de chiffres précis sur ses ventes, Amazon affirme en effet que le Kindle Fire est depuis son lancement le produit le plus vendu par Amazon aux États-Unis. Et sur les trois dernières semaines, la cadence de vente serait de plus d'un million d'unités par semaine. De quoi effectivement placer le Kindle Fire en numéro deux des tablettes, juste derrière l'iPad. Amazon a d'ailleurs dû augmenter la production de la tablette pour suivre la demande.

Ces résultats doivent par contre faire grincer quelques dents du côté de chez Google. En effet, la tablette Amazon est basée sur un système Android très fortement modifié par Amazon, qui en a retiré tous les services de Google. Et pendant qu'elles se vendent par millions, les tablettes sous une version standard d'Android peinent à trouver preneur...

Posté par Matt le 19/12/2011 à 12h59

Aucun commentaire

Source : 01Net

Western Digital et Seagate ont tous les deux annoncé leur intention de revoir à la baisse la durée de garantie de leurs disques durs à compter du début de l'année 2012.

Chez Seagate, toutes les garanties de 5 ans passent à 3ans, tandis que les garanties de 2 ans passent à 1 an. Les produits concernés sont les Constellation.2, Constellation ES.2, Barracuda XT et Momentus XT pour les garanties de 3 ans et les Barracuda, Barracuda Green et Momentus pour les garanties d'un an. Ces réductions ne concernent que les disques vendus nus, pas ceux vendus en boîte, qui conservent leurs garanties de 5 ans et 2 ans.

Du côté de Western Digital, qui offrait des garanties plus longues que son concurrent, la coupe est moins franche. Les modèles Blue et Green, qui étaient garantis 3 ans, ne seront désormais plus garantis que pour 2 ans, tandis que les modèles Black et Entreprise conservent leur garantie de cinq ans.

Cette baisse coïncide avec la reprise d'activité progressive des usines de production après les inondations qui ont touché la Thaïlande. Espérons qu'elle ne soit pas là pour anticiper une baisse de la qualité de production suite à l'augmentation des cadences et aux dommages subis par les installations...

Posté par Matt le 19/12/2011 à 10h20

Aucun commentaire

Source : Hardware.fr

Même si l'avenir des connexions à Internet passe sans doute par le déploiement de la fibre optique, certains continuent de penser que la technologie DSL, la plus utilisée actuellement pour les accès Internet haut débit, n'a pas dit son dernier mot.

En effet, alors que les offres commerciales en DSL plafonnent aux alentours de 25 Mbit/s en ADSL et 100 Mbit/s en VDSL, l'équipementier chinois Huawei a réussi a pousser la technologie DSL jusqu'à 1 Gbit/s, grâce à une astuce permettant une transmission full duplex sur un canal half duplex.

Ce débit ne peut toutefois être atteint que sur une centaine de mètres, mais pourrait être utile pour les terminaisons dans une infrastructure fibre optique de type FTTB, où le réseau optique s'arrête au pied de chaque immeuble, la liaison finale jusqu'à l'abonné s'effectuant via la boucle locale cuivre existante.

Posté par Matt le 19/12/2011 à 09h00

Aucun commentaire

Source : Tom's Hardware

Hier soir, Apple a ouvert en France son service iTunes Match, qui était jusqu'à présent réservé aux américains. Il sera facturé 24€99 par an.

À l'instar de Google Music (qui reste pour l'instant réservé aux américains... en théorie), iTunes Match permet de stocker votre bibliothèque musicale en ligne, pour y accéder depuis n'importe quel appareil compatible (Mac, PC ou appareil sous iOS 5). Mais contrairement à Google Music, il permet de se passer de l'étape d'envoi des fichiers vers les serveurs : les fichiers des titres déjà présents dans le catalogue de l'iTunes Music Store sont remplacés par la version proposée par Apple (AAC 256 kbit/s sans DRM). Les fichiers non reconnus sont envoyés vers les serveurs, dans la limite de 5000 titres par utilisateur.

Cette fonction de reconnaissance peut éventuellement justifier l'abonnement annuel, puisqu'elle peut permettre d'obtenir des enregistrements de meilleure qualité, mais l'offre de Google garde largement l'avantage sur le plan tarifaire, puisqu'elle permet d'envoyer sur les serveurs Google jusqu'à 20 000 titres gratuitement.

Posté par Matt le 16/12/2011 à 12h27

Aucun commentaire

Source : MacGénération

Le marché des GPS est aujourd'hui malmené par celui des smartphones, la plupart d'entre eux étant doté d'une puce GPS, permettant d'utiliser l'appareil pour la navigation automobile en ajoutant simplement une application. Mais les GPS dédiés n'ont pas dit leur dernier mot.

Pour se distinguer des smartphones, les constructeurs de GPS jouent notamment sur la taille de l'écran, avec des appareils dotées de dalles 5" ou plus, mais aussi sur le fonctionnement à l'international de tous les services. Sur ce point, TomTom frappe fort avec son nouveau Go Live 1005 World, qui contient la cartographie de tous les pays supportés par TomTom (45 pays européens dont 31 détaillés, Australie, Nouvelle-Zélande, États-Unis, Canada, Afrique Australe et Asie du Sud-Est).

Point fort de cette solution, un abonnement unique au service Live suffit à couvrir l'ensemble des pays où ce service est disponible, alors que les utilisateurs d'applications smartphone sur GPS devront disposer d'un forfait data fonctionnant dans tous les pays. L'abonnement aux services Live est d'ailleurs offert pendant un an aux acheteurs du Go Live 1005 World, qui est vendu un peu moins de 350€.

Pas sûr toutefois que cet argument soit suffisant pour assurer le succès de l'appareil, peu de gens ayant l'utilité d'une telle couverture cartographique, à part peut-être les amateurs de longs raids en moto ;-)

Posté par Matt le 16/12/2011 à 10h51

6 commentaires

Source : Übergizmo

![]()

L'ARCEP avait laissé jusqu'au 15 décembre aux opérateurs intéressés par une licence 4G 800 MHz pour se manifester. Sans surprise, la liste définitive des candidats dévoilée hier par l'ARCEP contient quatre noms : Bouygues Telecom, Free Fréquences, Orange et SFR.

Les quatre titulaires d'une licence 4G 2.6 GHz se sont donc portés candidats, tandis que personne d'autre ne pouvait demander une telle licence, les licences 800 MHz étant réservées aux titulaires d'une licence 2.6 GHz. L'ARCEP va maintenant se lancer dans l'étude des candidatures et devrait donner dans quelques semaines les détails des attributions.

Pour rappel, la bande 800 MHz a été divisée en quatre lots, vendus via une procédure d'enchère secrète à un seul tour, dont l'État espère tirer au moins 1.8 milliards d'euros. Un opérateur pouvant obtenir deux lots, les quatre candidats ne seront pas forcément servis, mais dans un tel cas, il pourra bénéficier d'un accord d'itinérance avec l'un des titulaires de la licence.

Posté par Matt le 16/12/2011 à 08h20

Aucun commentaire

Source : Tom's Hardware

Il y a quelques jours était révélée la liste des processeurs qui constitueront initialement la famille Ivy Bridge d'Intel l'année prochain. Si cette liste ne révèle pas de grande surprise par rapport aux rumeurs, elle apporte une information importante pour les utilisateurs mobiles.

En effet, alors que jusqu'à présent, tous les processeurs quadri-cœur mobiles d'Intel avaient un TDP d'au moins 45W, les cantonnant aux "gros" ordinateurs portables, la nouvelle gamme comportera au moins un modèle quadri-cœur d'un TDP de 35W, le i7-3612QM. Doté de 6 Mo de cache, ce modèle sera cadencé à 2.1 GHz, et pourra monter en mode turbo jusqu'à 2.8 GHz sur quatre cœurs, 3 GHz sur deux cœurs et 3.1 GHz sur un seul. Sa partie graphique sera cadencée à 1.1 GHz.

Il ne faudra par contre pas espérer top de ce processeur en terme d'autonomie, car il est visiblement à la limite de son enveloppe de 35W : le modèle supérieur n'est cadencé qu'à 200 MHz de plus (300 MHz en mode turbo sur quatre cœurs), mais ce petit supplément suffit à le faire basculer dans la tranche des 45W...

Posté par Matt le 15/12/2011 à 12h20

Aucun commentaire

Source : TTHardware

![]()

À l'occasion d'une conférence organisée par la Coalition française pour la diversité culturelle, Aurélie Filippetti, députée de Moselle et chargée de la mission Culture et Média par François Hollande, a évoqué les idées pour l'après Hadopi.

Tout d'abord, la députée à donné des pistes pour le financement de l'offre culturelle. Pour se faire, les socialistes envisagent la mise en place d'une taxe sur "les industries qui tirent réellement partie aujourd'hui des nouvelles technologies". Précisant sa pensée, elle explique que les sociétés visées seront "les FAI ... les fabricants de matériel, les Apple, iTunes, Google, etc". Une taxe à laquelle Dahlia Kownator, représentante de la Fédération Française des Télécoms, n'est pas totalement opposée, à condition que les FAI soient plus placés dans un rôle de percepteur que dans un rôle de payeur.

Aurélie Filippetti a également évoqué une "contribution créative", qui serait une sorte de licence globale basée sur le volontariat des internautes. Une version spéciale de cette contribution serait destinée aux étudiants. Prélevée en même temps que les droits d'inscription dans les établissement d'enseignement, elle leur donnerait un droit d'accès aux "contenus culturels numériques pendant le temps de leur étude", leur permettant ainsi de télécharger sans risque juridique. Une proposition forcément très mal accueillie par les représentants des ayant-droits...

Enfin, elle a rappelé que l'Hadopi ne devrait pas survivre en cas d'élection de François Hollande : "On abroge Hadopi, c’est sûr. Ce modèle est inefficace. (…) Pour la première fois nous avons eu une loi qui oppose public et artistes, les créateurs et ceux qui les soutiennent. Cela ne doit plus se reproduire, on doit s’en extirper."

Posté par Matt le 15/12/2011 à 08h11

1 commentaire

Source : PCInpact

![]()

L'ARCEP a publié hier un communiqué important : suite à sa campagne de mesure effectuée en différents endroits du territoire français, l'ARCEP confirme que le réseau Free Mobile a atteint la couverture que l'opérateur s'était engagé à couvrir pour le 12 janvier 2012.

L'ARCEP autorise donc Free Mobile à exploiter commercialement son réseau dès à présent, et l'accord d'itinérance avec Orange pour couvrir l'ensemble de la population entre en vigueur. Les offres commerciale devront être lancées au plus tard pour le 12 janvier 2012.

Selon Solveig Godeluck, du journal Les Échos, ce lancement commercial pourrait avoir lieu dès cette semaine. Il est vrai que si Free Mobile est prêt, il y a peu d'intérêt à attendre...

Comme pour confirmer l'imminence du lancement, Xavier Niel a publié hier un premier tweet public "the Rocket is on the launch pad" ("La fusée est sur le pas de tir").

Posté par Matt le 14/12/2011 à 10h30

Aucun commentaire

Source : Freenews

C'est désormais certain : la prochaine génération de chipsets Intel va bien supporter l'USB 3.0, comme le prouve la récente certification "SuperSpeed USB" accordée à ces chipsets par l'USB Implementer Forum.

Il était temps que cet USB 3 natif soit supporté. Il est en effet impensable aujourd'hui de proposer une carte mère haut de gamme sans USB 3.0, et les constructeurs de cartes mères étaient donc obligés de recourir à un contrôleur USB 3.0 complémentaire, sacrifiant ainsi des lignes PCI-Express, en plus de réduire les performances.

Les premiers chipsets Intel avec USB 3.0 seront les chipsets de la série 7, qui devraient sortir au second trimestre 2012, en même temps que les processeurs Ivy Bridge.

Posté par Matt le 14/12/2011 à 08h30

Aucun commentaire

Source : PCWorld

Lancé il y a quelques semaines pour constituer le milieu de gamme des liseuses Amazon, le Kindle Touch est théoriquement, comme ses prédécesseurs, exclusivement dédié à la lecture de contenus. Mais face aux bidouilleurs, la théorie ne tient souvent pas bien longtemps...

Yifan Lu a en effet réussi à obtenir un accès administrateur sur tout le système de son Kindle Touch (système basé sur Linux) en exploitant l'architecture de l'interface graphique en HTML et JavaScript pour injecter du code à partir d'un simple fichier MP3 : il lui a suffit d'insérer du code HTML et JavaScript dans les tags ID3 de ce fichier pour que le moteur de rendu de l'interface graphique exécute ce code lors du chargement du fichier dans le lecteur multimédia. Simple et efficace.

Comme démonstration de son "œuvre", il propose un nouvel écran de veille, mais aussi un package permettant de se connecter au système du Kindle Touch via SSH. Il espère ainsi permettre à des développeurs tiers de réaliser de nouvelles applications pour le Kindle Touch. L'ensemble est disponible sur le blog d'Yifan Lu.

Posté par Matt le 13/12/2011 à 12h50

Aucun commentaire

Source : Numerama

![]()

Il y a des entreprises qui ne connaissent pas la crise... Et la division téléphonie mobile de Samsung en fait visiblement partie, puisque le coréen a annoncé qu'il allait écouler 300 millions de téléphones mobiles en 2011.

C'est 20 millions (+7%) de mieux que l'année dernière et, en excluant les dimanche, se sont donc près d'un million de téléphones Samsung qui trouvent preneur chaque jour. De quoi conforter Samsung dans sa position de second plus gros vendeur de téléphones dans le monde, derrière Nokia.

Samsung doit bien entendu une partie de cette performance au succès de sa gamme de smartphones sous Android, en particulier les Galaxy S et S2, qui représentent à eux deux près de 10% du total, mais le gros du volume reste réalisé sur des téléphones plus basiques, qui devraient petit à petit céder leur place à des smartphones dans les années à venir.

Posté par Matt le 13/12/2011 à 10h10

Aucun commentaire

Source : Le Journal du Geek

Depuis un peu plus de trois ans, Bill Gates ne travaille officiellement plus pour Microsoft, même si le milliardaire n'as pas totalement coupé les ponts avec son bébé. Selon certaines informations, il pourrait revenir prochainement aux commandes.

C'est en tout cas ce que prévoit le site du magazine Fortune, qui tiendrait l'information d'une source interne à Microsoft. Un retour qui serait souhaité par les actionnaires de la société, qui ne sont pas totalement satisfait de la gestion de Steve Ballmer, qui remplace Bill Gates depuis son départ.

Il est vrai que même si Microsoft connait toujours le succès dans le secteur des ordinateurs et des consoles de jeu, Steve Ballmer n'a pas réussi à imposer son entreprise sur le marché des smartphones et des tablettes, qui est pourtant le plus gros vecteur de croissance actuel pour le monde de l'électronique et du logiciel. Il est peut-être encore un peu tôt pour enterrer définitivement Windows Phone 7, mais aux États-Unis, il n'a pas suffit à enrayer la chute de la part de marché de Microsoft sur les smartphones, qui a baissé de 45% depuis le lancement du système.

Posté par Matt le 13/12/2011 à 08h50

Aucun commentaire

Source : PCWorld

À l'occasion de l'ouverture des nouveaux locaux de Google en France, LCI a pu interviewer Eric Schmidt, président exécutif du moteur de recherche, qui a vivement critiqué la législation française sur le droit d'auteur.

Eric Schmidt considère en effet que le droit français est trop en faveur des auteurs, au détriment des droits du public. À ses yeux, le dispositif Hadopi est totalement disproportionné. Il estime que la lutte contre le piratage peut se faire sans lois spécifiques et que "couper l'accès à Internet ou demander aux fournisseurs d'accès de faire la police est une réaction excessive, il doit exister d'autres façons de régler ce problème". Il indique d'ailleurs avoir évoqué le sujet avec Nicolas Sarkozy : "Nicolas Sarkozy est au courant de nos réticences sur la loi Hadopi".

À la place des mesures actuelles, il suggère plutôt le recours au principe du "fair use", qui autorise le grand public à exploiter les œuvres dans le cadre d'un "usage raisonnable". Selon lui, le fair use est la clé pour redonner au pays sa capacité d'innovation dans le domaine des contenus culturels et des moyens d'y accéder. Aux États-Unis, la mise en place du fair use a effectivement permis le lancement de nouveaux modèles économiques, avec à la clé 4 700 milliards de dollars de chiffre d'affaire en cinq ans, soit 23% de la croissance économique des États-Unis sur cette période.

Malheureusement, Frédéric Mitterrand, actuel ministre de la culture, est opposé à toute réforme profonde du droit d'auteur, qui est pour lui parfaitement adapté aux technologies actuelles. Peu de chance donc qu'Eric Schmidt se fasse entendre...

Posté par Matt le 12/12/2011 à 14h30

1 commentaire

Source : Numerama

Proposée dans Picasa depuis quelques années, la fonction de reconnaissance faciale de Google fait sans surprise son arrivée dans Google+, sous le nom de Find My Face. Picasa a également été mis à jour au passage pour y intégrer Google+ et prendre en compte cette fonction.

Grâce à Find My Face, Google+ vous pourra reconnaitre les visages présents sur les photos que vous partagez, et vous suggérera automatiquement de les tager avec les noms des personnes reconnues. Pour éviter le tollé qu'avait provoqué Facebook en introduisant une telle fonction il y a quelques mois, cette fonction ne sera pas activée par défaut, et seuls les membres de Google+ ayant activé la fonction pourront être taggés automatiquement. Bien entendu, les personnes taguées seront notifiées, et auront la possibilité d'accepter ou de rejeter le tag.

Du côté de l'application Picasa, qui passe en version 3.9, Google+ fait son arrivée, et il est désormais possible de partager directement une photo sur Google+ à partir de Picasa. En cas de partage d'une photo dans laquelle des personnes sont identifiées, elle devra être partagée avec ces personnes (qui pourront alors accepter ou rejeter le tag) ou les tags seront supprimés.

Cette nouvelle version de Picasa apporte aussi de nouvelles fonctions de retouche photo, et notamment des effets tirés du kit de création de Google+.

Posté par Matt le 12/12/2011 à 12h30

Aucun commentaire

Sources : Génération NT et PCInpact

HP vient de décider du sort qu'il réserve à son système d'exploitation webOS, après avoir abandonné la production de tous les appareils l'exploitant et bradé les stocks restants à des prix défiant toute concurrence. Et les nouvelles sur l'avenir du système sont plutôt bonne.

En effet, alors que certaines rumeurs évoquaient l'utilisation exclusive de ce système dans les imprimantes du constructeurs, ce qui aurait tout de même largement sous-exploité ses possibilités, HP a finalement décidé de rendre son système open source, ce qui pourrait lui ouvrir de nouveaux horizons, à commencer par un retour sur le marché des tablettes et des smartphones.

HP n'a pas précisé quelle licence sera utilisée, mais a d'ores et déjà indiqué qu'il continuera à contribuer au projet et à le financer et qu'il souhaite mettre en place une gouvernance transparente et laissant participer les autres contributeurs, pour limiter les risques de forks.

Si HP parvient à séduire quelques autres contributeurs importants, webOS pourrait bien devenir une nouvelle alternative à Android.

Posté par Matt le 12/12/2011 à 11h10

Aucun commentaire

Source : Mac4Ever

En pleine crise sur le marché des disques durs, fortement touché par les inondations en Thaïlande, Hitachi vient de lancer discrètement un nouveau modèle de disque dur, atteignant la capacité record de 4 To.

Déjà disponible au Japon, le HDS5C4040ALE630 est un disque 3.5" fonctionnant à 5400 tours par minute (Deskstar 5K). Il embarque 32 Mo de cache, se connecte en SATA 6 Gbit/s et utilise l'Advanced Format, c'est-à-dire qu'il est doté de secteurs physiques de 4 Ko au lieu de 512 octets.

Il est vendu au Japon pour environ 260€, ce qui devrait l'amener à environ 310€ TTC par chez nous. Un tarif particulièrement raisonnable compte tenu de la capacité et des prix actuellement pratiqués pour les disques durs.

Posté par Matt le 12/12/2011 à 08h51

Aucun commentaire

Source : BH Mag

![]()

Grâce à diverses optimisations apportées à un de ses contrôleurs Bluetooth, Broadcom vient de faire une promesse qui va ravir les amateurs de périphériques sans-fil : des claviers sans-fil Bluetooth offrant 10 ans d'autonomie avec deux piles AA !

Pour parvenir à ce résultat, le constructeur a optimisé la couche logicielle de sa solution BCM20730, mais aussi ajouté une couche d'émulation USB HID grâce à laquelle le clavier n'a plus besoin d'émettre régulièrement des données de synchronisation Bluetooth. Ainsi, le contrôleur Bluetooth du clavier n'est allumé que lorsqu'une touche est pressée, économisant ainsi un maximum d'énergie entre les frappes.

Reste à voir si les performances de cette solution sont à la hauteur de ce qu'on peut attendre d'un clavier, en particulier en terme de réactivité : il faut espérer que le contrôleur Bluetooth démarre suffisamment rapidement pour qu'il n'y ait pas de ralentissements sensibles.

Posté par Matt le 09/12/2011 à 12h51

Aucun commentaire

Source : Macbidouille

Avec l'explosion des ventes de smartphones et de tablettes, le marché des processeurs mobiles connait une forte croissance, qui bénéficie directement à Qualcomm, solide leader sur ce marché grâce à ses solutions SnapDragon à base d'architecture ARM.

Le constructeur américain s'en en effet accaparé 49% des 2.24 milliards de dollars de chiffre d'affaire réalisés sur ce marché au troisième trimestre 2011 (contre 1.41 milliards il y a un an). Il est suivi par Samsung, Texas Instruments, Marvell et Broadcom, tandis que nVidia n'atteint que la sixième place avec son Tegra 2, probablement handicapé par le fait qu'il n'a été adopté quasiment que dans des tablettes.

La position de Qualcomm pourrait toutefois petit à petit s'affaiblir, le marché se tournant de plus en plus vers un découplage du processeur et du modem (59% de processeurs sans modem l'année dernière, 69% cette année), alors que Qualcomm a construit son succès sur une gamme qui était initialement constituée exclusivemnt de processeurs avec modem.

Posté par Matt le 09/12/2011 à 10h30

Aucun commentaire

Source : Génération NT

Asus a dévoilé il y a quelques jours ses objectifs de résultat pour l'année prochaine. Le taïwanais ne veut visiblement pas se contenter de sa position actuelle et, malgré la crise, place la barre haut par rapport à ses résultats de 2011.

Du côté des ordinateurs portables, plus gros marché d'Asus, le constructeur souhaite livrer en 2012 entre 19.3 et 19.8 millions de machines, contre 14.7 millions cette année, soit une hausse de l'ordre de 40%. De tels chiffres pourraient lui permettre de passer devant Dell au niveau mondial.

Sur le marché des tablettes, le succès de l'Eee Pad Transformer donne de l'ambition à Asus. Après avoir livré 1.8 millions de tablettes en 2011, le taïwanais s'est fixé l'objectif d'en écouler au moins 3 millions en 2012. Il semblerait même que les dirigeants de la firme visent officieusement des ventes deux fois plus élevées, pour faire passer Asus à la seconde place des constructeurs de tablettes, entre Apple et Samsung.

Pour ce qui est des cartes mères, Asus est moins ambitieux, et ne vise que 4 à 9% de croissance, en passant de 23 millions de cartes à 24-25 millions.

Enfin, les prévisions d'Asus confirment le désintérêt des consommateurs pour les netbooks, puisqu'Asus ne compte en vendre que 3 ou 4 millions en 2012, après en avoir écoulé près de 5 millions en 2011.

Posté par Matt le 09/12/2011 à 08h51

Aucun commentaire

Source : PCInpact

![]()

Alors que le lancement de Free Mobile n'est plus qu'une question de semaines, voir de jours, les informations et rumeurs au sujet du nouvel opérateur et de ses offres se font de plus en plus nombreuses...

Aujourd'hui, PCInpact a réussi à en savoir plus sur les offres de financement que proposera l'opérateur pour l'achat de terminaux mobiles. Comme l'avaient annoncé les rumeurs, ce financement se fera en partenariat avec Sofinco, sous la forme d'un crédit à la consommation renouvelable. Le capital emprunté pourra être compris entre 200 et 900€, avec un remboursement sur 12, 24 ou 30 mois.

Les documents reçus par PC Inpact indiquent un crédit à taux 0 "pour des modalités spéciales d'utilisation et de remboursement", et un TAEG de 19.23% dans les autres cas, sans préciser à quels cas s'appliquent le taux 0. Avec le taux 0, Free s'alignerait donc sur les offres de crédit de Sosh et de B&You, mais l'achat à crédit sera plus contraignant d'un point de vue administratif que l'achat d'un mobile subventionné couplé à un abonnement, puisqu'il faudra prouver sa solvabilité (ce qui n'est pas forcément une mauvaise chose...). Sofinco serait prêt à lancer cette offre dès le 15 décembre.

Du côté de Macbidouille, c'est la rumeur d'un pré-lancement avec envoi gratuit de cartes SIM aux abonnés Free ADSL qui refait surface. Free enverrait ces cartes SIM gratuites à partir du 17 décembre, pour une ouverture du service le 19. Cette fois-ci une information intéressante vient accréditer cette rumeur : une source de Macbidouille lui a indiqué qu'un opérateur mobile a prévenu La Poste qu'il allait procéder à un envoi massif de courriers à partir de la mi-décembre, avec une cadence d'au moins 50 000 par jour (à ce rythme, il faudrait tout de même trois mois pour équiper tous les abonnés ADSL... mais certaines rumeurs indiquaient aussi que cette carte SIM gratuite serait réservée aux abonnés disposant d'une Freebox Révolution, ce qui limiterait grandement le volume).

Posté par Matt le 08/12/2011 à 20h40

2 commentaires

![]()

Alors que Samsung est devenu cette année le premier constructeur de smartphones et le second constructeurs de téléphones mobiles, son compatriote LG est moins à l'aise depuis l'explosion du marché des smartphones. Le Coréen a perdu en un peu plus d'un an la moitié de sa part de marché, tombant à moins de 5%. Il compte désormais sur la 4G pour se relancer.

LG vient en effet de lever un milliard de dollars, via une augmentation de capital. La moitié de cette somme sera confiée au département R&D du constructeur, pour concevoir les futurs smartphones 4G. Avec un chiffre d'affaire en chute de 10% et 800 millions de dollars de pertes à éponger, LG a intérêt à réussir son coup.

La première offensive du coréen arrivera en février prochain, avec le lancement de pas moins de neuf nouveaux modèles, de l'entrée au haut de gamme.

Posté par Matt le 07/12/2011 à 12h51

Aucun commentaire

Source : PCWorld

![]()

Les firmwares pour la Freebox Révolution continuent de se succéder à un rythme rapide. Le boîtier Player de la Freebox Révolution est désormais en 1.1.4, avec quelques corrections et nouveautés pour l'occasion.

Nouvelles fonctionnalités

- Application Facebook

Corrections

Télévision

- Touches numériques de la télécommande non utilisables dans les champs de saisie lorsque l’appui long pour le zapping est activé

Lecteur multimédia

- Fichiers non listés lorsque leur nom contient des caractères spéciaux

- Freezes lors de la lecture depuis un disque dur connecté sur le Player

- Impossible d’envoyer un message contenant un point d’exclamation

Lecteur Blu-Ray

- Problème de lecture de certains disques Blu-Ray en 3D

Posté par Matt le 07/12/2011 à 10h27

Aucun commentaire

Source : L'actualité de la Freebox

Depuis de longues années, les processeurs AMD sont incapables de rivaliser avec les processeurs Intel sur le haut de gamme, souffrant à la fois d'un déficit de performances et d'une consommation plus élevée. AMD aurait du coup décidé de quitter ce segment de marché.

À la place, le fondeur envisagerait de se concentrer sur les puces basse consommation destinées aux appareils mobiles et au serveur utilisés pour les services de cloud computing. Il faut dire que sur ces secteurs, la situation d'AMD est bien plus favorable. Le processeurs APU de la gamme Fusion, destinés aux netbooks et aux tablettes, ont par contre une solide réputation, grâce à leur bon équilibre entre puissance processeur, puissance graphique et consommation, là où Intel ne propose que des Atom, sobres mais aux performances anémiques, et des Core i ULV, performants, mais onéreux, un peu gourmands, et peu rapides en graphisme.

Contrairement à ce que laissaient entendre certaines rumeurs, AMD restera par contre fidèle à l'architecture x86, que le fondeur connait depuis plus de 25 ans, plutôt que de basculer vers une architecture ARM, plus classique dans le domaine de la mobilité.

Posté par Matt le 07/12/2011 à 08h15

Aucun commentaire

Source : TT Hardware

![]()

Alors que plus de vingt procès sont en cours à travers le monde entre Apple et Samsung, une juge californienne vient de rendre une décision préliminaire intéressante, dans une affaire où Apple réclamait le blocage des ventes de trois smartphones Samsung et de la Galaxy Tab.

Pour appuyer sa demande, Apple accusait Samsung d'avoir violé différents brevets et d'avoir copié le design de l'iPhone. Dans sa décision, la juge californienne se range du côté d'Apple : elle considère que les brevets d'Apple sont à priori valides, et que les produits Samsung incriminés les violent effectivement. Mais, et c'est là que la décision devient intéressante, elle estime aussi que ses violations ne sont pas suffisantes pour justifier une interdiction des ventes de ces produits en attendant le terme du procès sur le fond du dossier, qui se tiendra l'année prochaine.

En clair, cela signifie que la juge considère que laisser les produits Samsung en vente n'engendre pas pour Apple un préjudice insupportable, et que si Apple venait à gagner le procès, ce préjudice pourrait être compensé financièrement par Samsung. Tout en donnant raison à Apple, la juge affaibli donc un peu la position de la firme à la pomme, en réduisant la valeur de ses brevets et du design de ses produits.

Rappelons également qu'en Australie, la cour qui avait interdit la vente de la Galaxy Tab s'apprête à lever l'interdiction, estimant après un nouvel examen que le brevet revendiqué par Apple n'était pas violé par Samsung.

Posté par Matt le 06/12/2011 à 14h30

4 commentaires

Source : Le Journal du Geek

Intel aurait-il décidé d'abandonner le marché des contrôleurs pour SSD ? Après avoir recyclé ses anciens contrôleurs dans les 320 Series et 710 Series et avoir adopté un contrôleur Marvell pour les 510 Series, le fondeur s'apprêterait à lancer sa nouvelle génération de SSD en s'appuyant sur des contrôleurs SandForce.

Alors que beaucoup espéraient qu'Intel produise enfin un nouveau modèle de contrôleur, après le succès des contrôleurs utilisés dans les X25, ce sont donc probablement des SandForce 2xxx qui équiperont les futurs 520 Series du fondeur. Il sera décliné en diverses capacités, allant de 60 Go à 480 Go.

Côté performances, ce sera dans la norme pour des SSD dotés de ces contrôleurs :

- 550 Mo/s en lecture séquentielle,

- 520 Mo/s en écriture séquentielle sur des données compressibles,

- 40 000 IOPS en lecture aléatoire 4K,

- 70 000 IOPS en écriture aléatoire 4K.

Ils se distingueront par contre de la concurrence par leur garantie, au niveau de ce qu'offre d'habitude Intel : 5 ans de garantie, avec une durée de vie minimale de 20 Go de données écrites par jour pendant 5 ans.

Posté par Matt le 06/12/2011 à 12h30

Aucun commentaire

Source : Tom's Harware

C'est LE scandale de ces derniers jours dans le monde de la téléphonie mobile : 150 millions de smartphones, sont livrés avec le logiciel espion Carrier IQ préinstallé à l'insu des utilisateurs par les opérateurs. Si le problème concerne en théorie uniquement les États-Unis, les régulateurs européens ont tout de même décidé de se pencher sur la question.

En France, la CNIL a annoncé avoir lancé une investigation sur le sujet, dans le but de déterminer si les opérateurs européens n'ont pas eux aussi recours à Carrier IQ ou tout autre logiciel aussi peu respectueux de la vie privée des propriétaires de smartphones. Au premier abord, il semblerait que ça ne soit pas le cas.

En Allemagne, c'est l'équivalent bavarois de la CNIL qui a formellement demande à Apple de s'expliquer sur sa politique vis à vis de Carrier IQ. Selon certaines sources, Carrier IQ serait présent sur tous les iPhone, et pas seulement les modèles américains, et serait utilisé directement par Apple, pas par les opérateurs. Apple a indiqué que la collecte de données ne se fait qu'avec l'accord de l'utilisateur, et que Carrier IQ a été supprimé de la plupart des appareils lors de la sortie d'iOS 5 et sera prochainement supprimé définitivement.

Enfin, aux États-Unis, c'est désormais au tour de la justice de prendre l'affaire en main. Un groupe d'américains a en effet initié un recours collectif auprès de la justice à l'encontre de Carrier IQ, AT&T, Sprint, T-Mobile, Apple, HTC, Motorola et Samsung. Les avocats conseillant les plaignants reprochent à ces entreprises d'avoir violer le Federal Computer Fraud and Abuse Act, le Federal Wiretap Act et le Stored Electronic Communications Act.

Posté par Matt le 06/12/2011 à 11h00

Aucun commentaire

Sources : Génération NT et Mac Génération

![]()

Réputé pour ses baladeurs multimédia, Cowon vient de présenter se première tablette, la Cowon R7. Un produit surprenant à plus d'un titre, mais malheureusement pas forcément de façon très positive...

Au format 7", la Cowon R7 commence par se démarquer par sa définition : là où la plupart des tablettes 7" sont dotés d'une définition de 1024x600, les utilisateurs devront se contenter d'un simple 800x480. Une définition qu'on trouve généralement plutôt sur des smartphones... Elle se distingue aussi par son OS : Windows CE 6.0. Un système qui n'a à ma connaissance encore jamais été utilisé dans un produit grand public (il sert par contre de base à l'OS du Zune HD et à Windows Phone 7), ce qui risque de limiter fortement la logithèque de la tablette.

Enfin, et c'est sans doute le point le plus surprenant : elle ne dispose pas de connectivité Wi-Fi. Ainsi, il est impossible d'utiliser cette tablette pour surfer sur Internet, suivre l'actualité ou relever ses e-mails. La Cowon R7 est donc quasi-exclusivement dédiée à la lecture de contenus multimédias. Sur ce point, elle s'annonce d'ailleurs plutôt efficace : supports de nombreux formats (dont le FLAC, l'APE et le MKV), lecteur vidéo 1080p, 64 Go de stockage, extensible par microSD, sortie HDMI, 10h d'autonomie en vidéo, 65h en audio...

Cowon n'a pas encore communiqué le prix et la date de disponibilité de l'appareil. Pour faire passer la pilule de l'absence de Wi-Fi, Cowon devra pratiquer une politique tarifaire particulièrement agressive, ce qui n'est malheureusement pas dans les habitudes de la marque.

Posté par Matt le 06/12/2011 à 08h26

Aucun commentaire

Source : Tom's Hardware

Il y a un mois, nVidia présentait son nouveau SoC Tegra 3. Un SoC aux caractéristiques prometteuses, avec ses 4 cœurs à 1.2 GHz et son cinquième cœur basse consommation, pour lequel le fondeur a de grosses ambitions, puisqu'il vise pas moins de 25 millions d'unités en 2012.

Un objectif qui risque toutefois d'être difficile à atteindre dans le contexte actuel. Tout d'abord, nVidia a choisi de rester sur une architecture Cortex A9. Si elle lui permet de lancer son SoC quadri-cœur avant tout le monde, cette architecture est moins efficaces que le Cortex A15 qu'on retrouvera dans quelques mois chez les autres constructeurs : TI OMAP5, Qualcomm SnapDragon S4, Samsung Exynos 5250... Ce dernier pourrait d'ailleurs parvenir à surpasser les performances du Tegra 3 avec seulement deux cœurs, grâce à sa fréquence élevée, ce qui pourrait lui donner un gros avantage sur les applications ne tirant pas parti de plus de deux cœurs.

L'objectif sera d'autant plus difficile à tenir que la version ARM de Windows 8 ne devrait arriver qu'en 2013, limitant ainsi le gros du marché du Tegra 3 aux tablettes Android. Un marché qui peine à décoller, et sur lequel nVidia n'avait déjà pas tenu ses objectifs de vente pour le Tegra 2, également fixés à 25 millions d'unités.

Posté par Matt le 05/12/2011 à 15h01

Aucun commentaire

Source : Génération NT

Google continue de se diversifier, et il se murmure aux États-Unis que la prochaine étape pour le géant de l'Internet pourrait être de se lancer dans... la livraison de biens à domicile ! Avec Amazon en ligne de mire.

En effet, depuis qu'il a lancé un service offrant la livraison sous 24h pour 79$ par an, Amazon connait une forte progression de ses ventes (+42% sur les trois premiers trimestres de 2011) et vient concurrencer le comparateur de prix de Google, de plus en plus de gens effectuant leurs recherches de produits directement sur Amazon, plutôt que de la faire sur Google.

Pour son service, Google envisagerait de proposer une livraison sous 24h, comme Amazon, mais sans abonnement annuel. Le firme de Mountain View se rémunérerait auprès des boutiques en ligne, en prenant une commission sur les ventes transitant par son service. Google aurait déjà entamé les discussions à cet effet avec différents distributeurs américains, dont Macy's, l'une des grandes chaînes de magasins du pays.

Posté par Matt le 05/12/2011 à 12h41

Aucun commentaire

Source : Numerama{{

La France est, et de loin, le pays de l'Union Européenne où la redevance copie privée est la plus élevée, ce qui pousse bon nombres de français à faire leurs achats à l'étranger, engendrant un manque à gagner conséquent pour les boutiques françaises. Considérant les ayants droits comme responsable de ce manque, Rue du Commerce les a attaqués en justice... et a gagné !

Les arguments de Rue du Commerce étaient les suivants :

- Copie France a failli à son obligation de résultat dans la collecte des redevances : théoriquement, elles devraient également être collectées sur les achats faits à l'étranger,

- les ayants droits n'ont fait aucun effort pour harmoniser les montants de redevance pratiqués dans les différents pays de l'Union Européenne,

- les ayants droits ont perçu des rémunérations illégales, annulées à plusieurs reprises par le Conseil d'État.

Des arguments qui ont fait mouche auprès du Tribunal de Grande Instance de Nanterre, qui reconnait que le montant perçu est beaucoup plus élevé que chez nos voisins (par exemple, la taxe est 12 fois plus élevée qu'en Allemagne sur les CD et 6 fois sur les DVD). Le non respect de l'obligation de résultat est également validé, d'autant que Rue Du Commerce a prouvé que même un français honnête qui déclare ses achats faits à l'étranger ne reçoit pas de facture de Copie France.

Le TGI reproche également à Copie France de ne pas avoir suffisamment informé les consommateurs français de leur obligation de s'acquitter de la redevance, et de n'avoir rien fait pour tenter de s'assurer du règlement de la redevance par les sites marchands étrangers.

En conséquence, le TGI a donné raison à Rue du Commerce, et a condamné Copie France à lui verser un million d'euros de dommages et intérêt. Copie France a bien entendu fait appel de la décision...

Il est important de noter qu'en cas de victoire définitive de Rue du Commerce, ce procès pourrait faire des petits : la condamnation ne concerne que Rue du Commerce, et uniquement pour le manque à gagner sur les CD/DVD. Il ne serait pas surprenant que Rue du Commerce vienne également réclamer des indemnités pour les ventes de tous les autres appareils assujettis à la redevance. D'autres boutiques françaises pourraient également être tentées de venir réclamer leur part.

Posté par Matt le 05/12/2011 à 10h16

Aucun commentaire

Source : PCInpact

![]()

Samsung a levé le voile sur son prochain SoC double-cœur, l'Exynos 5250, qui sera le premier SoC Samsung basé sur la nouvelle architecture ARM Cortex A15. Il s'agit d'un SoC haut de gamme, qui pourrait bien équiper le futur smartphone Galaxy SIII.

Cadencé jusqu'à 2 GHz, la partie processeur sera deux fois plus performante que celle du haut de gamme actuel de Samsung, basé sur un Cortex A9 double-cœur à 1.2 GHz, l'Exynnos 4250. La partie graphique sera confiée à un cœur ARM Mali T604, qui promet un quadruplement des performances, tant en 2D qu'en 3D.

Ces hautes performances permettront de piloter des écrans très haute résolution, jusqu'à 2560x1600 (la résolution habituellement utilisée par les écrans PC 30") et de supporter la 3D stéréoscopique.

Cette nouvelle puce devrait être disponible à partir du second trimestre 2012.

Posté par Matt le 05/12/2011 à 08h41

Aucun commentaire

Source : FrAndroid

Difficile de l'ignorer aujourd'hui, Apple est en procès avec bon nombre de ses principaux concurrents sur le marché des tablettes et des smartphones. Dans ce contexte, The Verge a trouvé un document particulièrement cocasse, dans lequel Apple donne des conseils à ses concurrents pour éviter d'être poursuivis par Apple...

Accrochez vous, c'est du lourd !

Comment faire un smartphone sans se faire attaquer par Apple ?

- ne pas utiliser le noir pour la façade avant,

- éviter les formes rectangulaires à angles arrondis,

- ne pas centrer l'écran sur la façade de l'appareil,

- ne pas placer le haut-parleur derrière une fente horizontale,

- orner la façade de motifs,

- couvrir toute la façade avec l'écran.

Et pour les tablettes ?

- éviter les formes rectangulaires à angles arrondis,

- ne pas mettre une mince bordure autour de la dalle,

- ne pas faire une surface totalement plane,

- orner la façade de motifs.

Apple revendique donc le monopole sur les rectangles à coins arrondis, sur les smartphones noirs (par contre, pour les tablettes, c'est autorisé...), les écrans centrés, les dalles plates et les designs sobres, sans fioritures... Ce qui est certain, c'est que les gens qui ont rédigé ce document, eux, ne devaient pas être complètement sobres... Heureusement que le ridicule ne tue pas...

Posté par Matt le 03/12/2011 à 22h11

Aucun commentaire

Source : Macbidouille

L'affaire fait de plus en plus de bruit sur Internet : les usages des utilisateurs américains de smartphones sont tracés Carrier iQ par un logiciel espion installé sur la plupart des smartphones par certains opérateurs américains.

Repérés dans un premier temps sur des appareils sous Android, le logiciel, quasiment impossible à désinstaller, permet de tracer énormément de choses : niveau de réception réseau, déplacements, messages, historique des appels, saisies au clavier... Le but officiel de la présence du logiciel est de permettre un meilleur diagnostic des dysfonctionnements, et de détecter les points faibles du réseau pour l'améliorer.

Il a ensuite été rapidement identifié sur des appareils exploitant d'autres systèmes qu'Android : les Blackberry et les smartphones Nokia sous Symbian. Seul Apple semblait être épargné, le constructeur étant d'ailleurs connu pour ne laisser quasiment aucune souplesse aux opérateurs pour la personnalisation des terminaux, contrairement à la plupart des autres constructeurs. Mais en creusant un peu, le hacker Chpwn, bien connu de la scène du jailbreak iPhone, a fini par trouver des traces de la présence de l'espion sur les terminaux à la pomme exploitant iOS 3 et supérieur... L'écrasante majorité des smartphones utilisés aux États-Unis est donc concernée par ce logiciel espion.

Les utilisateurs européens seraient par contre à priori épargnés. En effet, aux États-Unis, vu la taille du marché, les opérateurs ont beaucoup de poids et parviennent à imposer Carrier iQ aux constructeurs de smartphones, en refusant quasiment de vendre des appareils qui n'en sont pas dotés. En Europe, le marché global est du même ordre d'importance qu'aux États-Unis, mais est fragmenté entre des dizaines d'opérateurs dans de nombreux pays, ce qui limite le poids de chaque opérateur. Les personnalisations opérateur sur les smartphones sont donc beaucoup plus minimalistes et n’incluraient pas ce genre de logiciel espion.

Posté par Matt le 02/12/2011 à 12h59

1 commentaire

Source : BusinessMobile

Parmi les 57 objectifs fixés à l'horizon 2020 lors des Assises du Numérique, le premier ministre François Fillon a évoqué l'engagement de l'État sur la couverture du pays en très haut débit grâce à la fibre optique, avec un objectif ambitieux.

En effet, l'État vise une couverture fibre pour 70% de la population en 2020 et 100% en 2025. Les investissement nécessaires pour atteindre cet objectif ont été chiffrés à 21 milliards d'euros sur dix ans. L'État compte sur les opérateurs privés et sur les collectivités locales pour mettre la main à la poche et financer ce grand projet, dans lequel l'État n'investira que 2 milliards d'euros.

Il se pourrait toutefois que ce chiffre soit revu à la hausse, en fonction de la situation et de l'avancement du chantier. En effet, François Fillon a indiqué que les FAI se sont engagés à fibrer 3600 communes, regroupant 57% des foyers, mais que l'État est prêt à "reprendre la main si ce n'est pas le cas". On peut donc supposer que l'État envisage soit d'augmenter sa subvention si le chantier prend du retard, soit mettre la pression (amendes ?) sur les FAI pour les pousser à respecter les objectifs fixés.

Posté par Matt le 02/12/2011 à 10h21

1 commentaire

Source : PCInpact

![]()

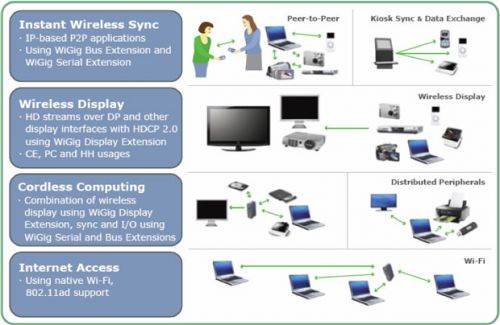

Depuis quelques temps, le nouveau dada d'Intel, c'est les ultrabooks, des ordinateurs ultra-portables embarquant des processeurs puissants. Pour les rendre plus utilisables sur un bureau, Intel travaille sur différentes solutions de docks, dont une intéressante solution sans-fil.

Le fondeur compte en effet pousser les constructeurs à proposer des ordinateurs et des docks exploitant la norme WiGig, une norme de communication sans-fil à très haut débit. Fonctionnant avec des signaux à 60 GHz, cette norme est assez peu adaptée à la réalisation de réseaux sans-fil, du fait de la faible portée des ondes à de telles fréquences. Mais la portée est tout de même suffisante pour permettre la réalisation de docks qui, placés à une courte distance de l'ordinateur portable, permettront d'étendre aisément ses capacités sans avoir à effectuer de branchement.

Pour les utilisations nécessitant un maximum de performances, Intel planche également sur des docks dotés d'une connectique standard avec une fiche combinant un signal ThunderBolt et l'alimentation de l'ordinateur.

Posté par Matt le 02/12/2011 à 08h35

Aucun commentaire

Source : PCWorld

Comme Google en début d'année, Facebook était sous le coup d'une enquête de la Federal Trace Commission aux États-Unis suite à des plaintes d'associations de consommateurs craignant les pratiques de Facebook par rapport aux données personnelles et au respect de la vie privée. Ce comme Google, Facebook a finalement réglé l'affaire à l'amiable, avec de lourdes contraintes.

En effet, à l'instar de son concurrent, Facebook a accepté d'être placé sous la surveillance de la FTC pour les vingt prochaines années, à raison d'un audit indépendant tous les deux ans. Le premier audit devrait avoir lieu en 2012.

Facebook s'est également engagé à ne plus modifier les paramètres de confidentialité sans l'accord explicite de ses membres. Facebook avait déjà été plusieurs fois pointé du doigt sur ce point, le réseau social ayant pris la mauvaise habitude de déployer les nouvelles valeurs par défaut chez tous ceux qui avaient laissé les anciennes valeurs, même si la nouvelle valeur impliquait une augmentation du niveau de diffusion de certaines valeurs.

Posté par Matt le 01/12/2011 à 14h21

Aucun commentaire

Source : Numerama

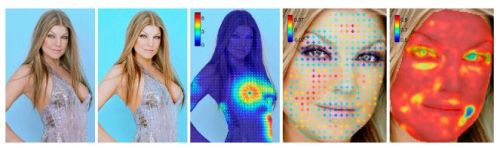

Les magazines et les sites Internet regorgent aujourd'hui de photos retouchées, pour gonfler une poitrine, effacer des rides, aplatir un ventre ou pire, créer une mise en scène et la faire passer pour la réalité. Grâce à deux chercheurs, ces supercheries pourront bientôt être mises en évidence.

Grâce à l'aide de 350 bénévoles, qui ont jugé du niveau de retouche d'un panel de 450 couples de photos (originale et retouchée), Hany Farid et Eric Kee, du Dartmouth College de Hanovre (celui du New Hampshire, pas celui d'Allemagne) ont mis au point un logiciel d'analyse d'images intelligent qui a appris à déterminer grâce à huit critères si une photo a été retouchée ou non. Il permet également de mettre en évidences les zones de l'image qui ont été modifiées.

Le logiciel atteint une efficacité de 80% sur les photos de personnes et devrait prochainement être adapté à d'autres types de photos.

Si les chercheurs décident de le publier, ce logiciel pourrait bien provoquer quelques surprises, et ils risquent de ne pas se faire que des amis...

Posté par Matt le 01/12/2011 à 12h20

3 commentaires

Source : Numerama

Votre téléphone ne cesse de sonner à cause de démarcheurs ? Bonne nouvelle, le système Pacitel, qui avait été annoncé en septembre, entre en service aujourd'hui. Il s'agit en quelque sorte d'un service "opt-out" couvrant un grand nombre d'entreprises de télémarketing.

Issu d'un accord entre l'État et cinq fédérations professionnelles liées au télémarketing (Association Française de Relation Client, Fédération du E-commerce et de la Vente à Distance, Fédération Française des Télécoms, Fédération de la Vente Directe et Syndicat National de la Communication Directe) représentant 80% des entreprises françaises effectuant du démarchage téléphonique, le système Pacitel permet aux particuliers d'inscrire leurs numéros de téléphone sur une sorte de liste rouge interdisant à ces entreprises de pratiquer du démarchage sur ces numéros.

En outre, une loi votée en octobre dernier oblige toutes les entreprises à consulter cette liste avant tout démarchage téléphonique. Les entreprises adhérentes au dispositif Pacitel se sont également engagées à respecter une plage horaire raisonnable pour leurs appels (8h à 20h30 en semaine, 9h à 19h le samedi) et à prendre des mesures sociales vis à vis de leurs démarcheurs.

Avant même son ouverture, le dispositif a connu un succès notable, avec déjà 500 000 personnes pré-inscrites, pour un total de 800 000 numéros de téléphones.

Pour vous inscrire, ça se passe par ici.

À quand la même chose pour les e-mails ?

Posté par Matt le 01/12/2011 à 10h50

2 commentaires

Source : Univers Freebox

Toujours à la recherche de nouvelles ponctions pour financer la création, les acteurs de l'audiovisuelle viennent d'avoir une nouvelle idée, soutenue par la Société des Auteurs et Compositeurs Dramatiques : taxer la bande passante Internet...

Pour justifier cette position, la SACD indique que selon les estimations de différents experts, dans quelques années, 75% du trafic Internet sera dédié à transmettre de la vidéo. Selon la SACD, une telle taxe aurait l'avantage de taxer indirectement les entreprises étrangères, pour les faire contribuer elles aussi à la création.

Elle insiste également que l'idée de cette taxe va dans la même direction que la volonté des opérateurs de faire payer la bande passante aux fournisseurs de contenus, qui sont à l'origine des besoins en bande passante et qui gagnent de l'argent grâce à cette bande passante, mais refusent de la payer.

Malheureusement, si une telle taxe était effectivement mise en place, il y a fort à parier qu'en pratique, elle sera payée par l'abonnée, et non par les fournisseurs de contenus, et surtout pas ceux basés à l'étranger...