L’été approche et avec lui, ses potentiels chaleurs caniculaires. La question du refroidissement de votre machine va donc forcément revenir sur le tapis. Voici donc quelques clés techniques qui vous permettront de savoir si vous êtes bien armé pour cette épreuve.

Quasiment toute l’énergie électrique consommée par nos ordinateurs est convertie en chaleur. Pour éviter que les composants surchauffent, il faut donc évacuer toute cette chaleur, grâce à diverses techniques et phénomènes physiques, dont le choix dépend principalement de la quantité d’énergie à évacuer et de la surface disponible pour ce faire.

La convection naturelle

Le refroidissement par convection naturelle est le mode de refroidissement le plus basique, puisque c’est en fait celui qui consiste tout simplement… à ne rien faire. Tout composant chaud (source chaude) au contact d’air plus frais (source froide) échange de la chaleur avec lui, en quantité proportionnelle à la surface de contact, à l’écart de température (delta) entre l’air et la surface et à un facteur dépendant du matériau utilisée (une surface en plastique échangera moins de chaleur qu’une surface en aluminium par exemple). L’air réchauffé à la surface du composant devient alors plus léger que l’air frais ambiant, ce qui engendre des mouvements de convection, l’air chaud cédant sa place à de l’air plus frais (si la surface chaude n’est pas située au-dessus de l’air, auquel cas l’air chaud va s’accumuler sur la surface), entretenant ainsi l’efficacité du refroidissement, qui diminuerait rapidement sans la convection, du fait de la baisse du delta de température.

Avec la hausse de la consommation des puces, il est devenu nécessaire d’aider un peu cette convection naturelle, ce qui se fait principalement par deux moyens : les radiateurs et la convection forcée, les deux pouvant être combinés.

Le radiateur

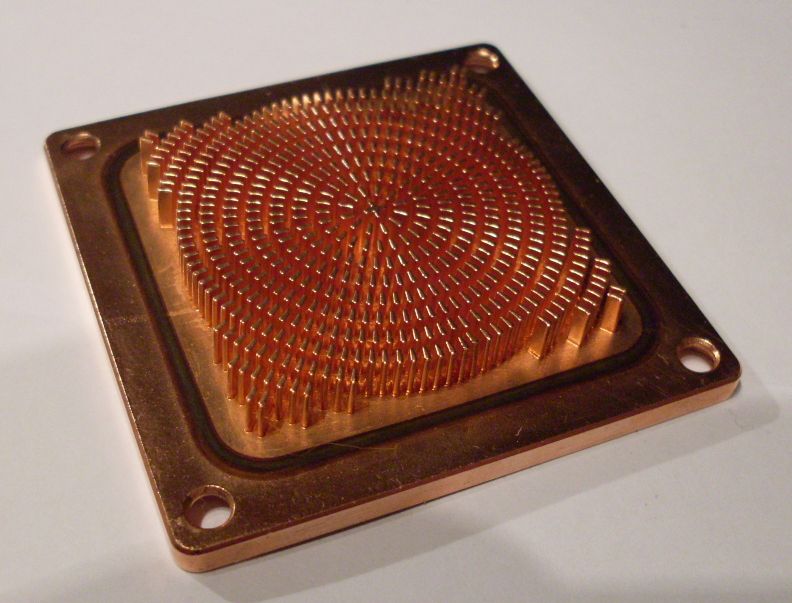

Le rôle du radiateur est tout simple : il sert d’intermédiaire entre la source chaude et la source froide, pour accélérer les échanges thermiques entre les deux. Pour ce faire, il est mis en contact direct avec la source chaude (éventuellement avec de la pâte thermique pour éviter les « bulles » d’air si les deux surfaces ne sont pas parfaitement lisses), pour qu’il puisse en absorber rapidement la chaleur par conduction thermique (la conduction étant bien plus efficace que la radiation, elle permet d’évacuer bien plus de chaleur via une même surface). Derrière cette chaleur est dissipée vers la source froide, mais à travers une surface bien plus grande que celle du composant, le radiateur disposant d’une surface très découpée.

L’efficacité du radiateur va dépendre principalement de trois facteurs :

- La conductivité thermique du matériau constituant l’interface entre le radiateur et le composant à refroidir.

- La conductivité thermique du matériau constituant la surface du radiateur.

- La surface de dissipation du radiateur.

Les matériaux les plus couramment utilisés pour les radiateurs de processeurs sont aujourd’hui le cuivre pour la base du radiateur, car il a une très bonne conductivité thermique, et l’aluminium pour sa surface, ce dernier permettant de limiter le coût et le poids du radiateur. Pour les puces moins gourmandes, les radiateurs sont généralement intégralement en aluminium.

Du fait de son inertie thermique, le radiateur permet aussi de réduire la vitesse des variations de température de la puce : lorsque la consommation de la puce augmente, il faut que le delta de température augmente pour que la puissance puisse être dissipée. Le radiateur va alors lisser ces variations en stockant plus ou moins de chaleur. Pour une même surface de dissipation, un radiateur plus massif offrira donc de meilleurs résultats. Les températures extrêmes à l’équilibre seront les mêmes, mais les variations seront plus douces.

La convection forcée

Quand la quantité de chaleur à dissiper devient importante, la convection naturelle peut ne plus être suffisante pour assurer un bon renouvellement de l’air frais qui baigne la surface de dissipation, surtout que de nombreux obstacles peuvent freiner la convection naturelle : câbles, boîtier, mais aussi les ailettes des radiateurs, en particulier lorsqu’elles sont peu espacées pour maximiser le rapport surface/volume… La solution à ce problème est la convection forcée, qui, comme son nom l’indique consiste à forcer les mouvements d’air, par exemple à l’aide d’un ventilateur.

L’efficacité de la ventilation se mesure principalement avec deux paramètres :

- Le débit d’air, dont va dépendre la quantité de chaleur évacuée.

- La pression statique du flux d’air, qui caractérise sa capacité à circuler malgré les obstacles.

De manière générale, il vaut mieux privilégier le débit pour des ventilateurs de boîtier, dont le rôle est de renouveler l’air intérieur, pas de refroidir directement un composant, tandis qu’il vaut mieux privilégier la pression statique pour les ventilateurs montés sur un radiateur, pour s’assurer que le flux d’air pénètre au maximum dans les entrailles du radiateur.

Les caloducs

Pour maximiser l’efficacité d’un radiateur, il faut que les transferts thermiques entre sa base et sa surface se fassent le plus vite possible, et avec un maximum d’homogénéité. Pour un petit radiateur, il est facile d’y parvenir en fixant simplement les ailettes sur la base (souvent, les deux sont mêmes d’une seule pièce). Mais pour un gros radiateur de processeur, c’est quasiment impossible, d’autant plus que compte tenu de l’obstacle que constitue la carte mère, il est préférable de privilégier un flux d’air parallèle à celle-ci, et donc, des ailettes parallèles à la base du radiateur…

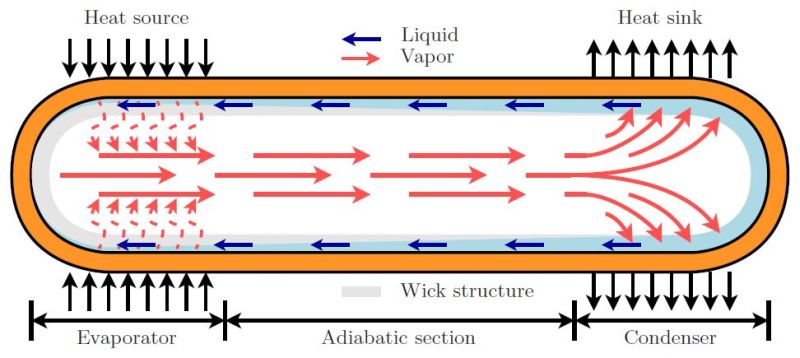

C’est à ce niveau qu’interviennent les caloducs (ou « heatpipe » pour les anglophones). Les caloducs sont des petits tuyaux métalliques contenant un fluide, et qui servent à assurer un transfert rapide de chaleur par changement de phase : le fluide emmagasine de la chaleur en s’évaporant du côté de la source chaude (base du radiateur) puis va la restituer en se condensant du côté de la source froide (ailettes). Le liquide condensé peut ensuite revenir vers la source chaude, par capillarité au sein d’une mousse ou d’une structure maillée qui tapisse les parois du caloduc.

La plupart des radiateurs haut de gamme utilisent aujourd’hui ce principe, souvent poussé à l’extrême, avec des ailettes qui ne sont plus du tout en contact direct avec la base, toute la chaleur à dissiper leur étant apportée par les caloducs.

Le refroidissement liquide

Enfin, quand la quantité de chaleur produite augmente encore un peu, il faut recourir aux grands moyens : le refroidissement liquide. Au lieu d’un radiateur, le composant à refroidir est surmonté d’un bloc parcouru par un circuit de liquide (waterblock), qui permet d’évacuer bien plus de chaleur que l’air. La capacité thermique massique de l’eau (c’est-à-dire la quantité d’énergie nécessaire pour augmenter de 1°C la température d’1 kg d’eau) est 4 fois plus élevée que celle de l’air, et un circuit de refroidissement liquide brasse une masse d’eau bien plus importante que la masse d’air brassée par la ventilation.

Le circuit de liquide étant généralement fermé, contrairement au circuit d’air, il faut par contre toujours un radiateur, et éventuellement un système de ventilation, pour refroidir le liquide. Dans certains cas (datacenters), le refroidissement du liquide est assuré par un circuit liquide ouvert.

L’intérêt principal d’un tel système est le déport du radiateur, qui permet alors de disposer de plus de souplesse dans son positionnement et dans sa dimension. Cela permet d’améliorer les performances de refroidissement avec un même niveau de ventilation (et par extension, permet de réduire le niveau de bruit pour un même niveau de refroidissement). D’autre part, un système de refroidissement liquide avec réservoir offrira bien plus d’inertie qu’un système où tout le liquide est dans les tuyaux. Enfin, le refroidissement liquide permet également de réduire le nombre de ventilateurs en refroidissant plusieurs composants avec un seul couple radiateur/ventilateur.

En contrepartie, les systèmes de refroidissement liquide classiques sont plus complexes à mettre en place et plus encombrants qu’un système de refroidissement à air, puisque c’est toujours l’air qui est utilisé pour refroidir le liquide : pour une même quantité d’énergie à dissiper et une même température cible à l’équilibre, la surface de dissipation du radiateur (donc son encombrement) doit être la même qu’en refroidissement à l’air, mais il faut en plus compter l’encombrement de la tuyauterie… De même, le coût de revient est plus élevé, et peut même assez vite s’envoler dans le cas d’un système de refroidissement complet, incluant le processeur, une ou deux cartes graphiques, la carte mère, voir même parfois les disques durs…

Quel refroidissement choisir ?

Alors, quel est le meilleur système de refroidissement pour vos besoins ? Tout dépend de vos moyens, de votre configuration et de vos oreilles… Alors qu’il y a quelques années le watercooling était quasiment indispensable pour réaliser une configuration haut de gamme vraiment silencieuse, c’est beaucoup moins vrai aujourd’hui, avec l’amélioration de l’efficacité énergétique des composants. Il est de nouveau tout à fait possible d’obtenir une configuration à la fois performante et silencieuse (et même passive en faisant quelques compromis sur les performances), le tout pour un prix bien plus raisonnable qu’en watercooling.

Le point important pour y parvenir est de ne pas négliger la ventilation du boîtier. Il peut en effet être tentant de supprimer les ventilateurs du boîtier, qui ne soufflent pas directement sur un radiateur, pour réduire le niveau de bruit. Mais ce faisant, l’air à l’intérieur se renouvellera beaucoup moins, et la température intérieure va donc augmenter… Augmentation qui sera suivie par les radiateurs, pour maintenir le delta de température nécessaire à la dissipation de l’énergie. Et inutile de compter sur un boîtier en aluminium pour compenser : même si ce matériau est plus efficace que l’acier pour dissiper la chaleur, son impact sur le refroidissement de la machine est le plus souvent négligeable, d’autant plus que les parois des boîtiers en aluminium sont souvent plus épaisses que celles des boîtiers en acier.

Paradoxalement, il peut en fait même être préférable de multiplier les ventilateurs pour gagner en silence : pour un même volume d’air brassé, deux ventilateurs à basse vitesse seront souvent plus silencieux qu’un seul à plus haute vitesse, tout en homogénéisant mieux le flux d’air dans le boîtier. Il ne reste alors plus qu’à choisir correctement les ventilateurs, ce qui n’est pas forcément toujours une chose aisée, tant les références sont nombreuses.

Côté processeur, le couple ventilateur/radiateur livré avec le processeur fait généralement bien l’affaire, pour un prix défiant toute concurrence, sauf pour les oreilles les plus exigeantes. Si vous préférez envisager un autre modèle, mieux vaut opter pour un radiateur de type « tour », dont les ailettes sont parallèles à la carte mère : il bénéficiera ainsi du flux d’air du boîtier, ce qui permettra d’utiliser une aération du CPU légèrement plus lent. Au niveau du ventilateur, il faut privilégier la pression statique, si possible avec un modèle disposant d’une plage de fonctionnement relativement large, pour pouvoir moduler sa vitesse en fonction des besoins en refroidissement.

Pour les ventilateurs du boîtier, il vaut mieux privilégier le rapport débit/bruit et cibler des ventilateurs fonctionnant naturellement à basse vitesse, plutôt que des ventilateurs rapides qui nécessiteront d’être sous-voltés pour fonctionner en silence, souvent avec un rapport débit/bruit moins favorable.

Le résultat idéal est de parvenir à une ventilation suffisante pour la machine à pleine charge, même lorsque tous les ventilateurs sont à leur vitesse minimale. Ce n’est malheureusement pas toujours possible, et il peut alors être bon de prévoir un système de modulation de la vitesse. Pour le ventilateur du CPU, la plupart des cartes mères d’aujourd’hui font correctement le travail, mais elles ne sont par contre généralement pas capables de piloter l’ensemble des ventilateurs de la machine.

Dans ce cas, il peut être intéressant d’investir dans un rhéobus, un périphérique qui se monte généralement dans une baie 2.5″ ou 3.5″ et permet de piloter un certain nombre de ventilateurs. Il y en a pour presque tous les goûts, seuls les amateurs de façades sobres risquent de ne pas trouver leur bonheur : la nuisance visuelle vient souvent remplacer la nuisance sonore…

Comme pour les ventilateurs, le choix est large, avec des caractéristiques très variables. De préférence, pour les ventilateurs non PWM, optez pour un rhéobus proposant des variateurs analogiques (potentiomètres) plutôt que numériques (commandés par des boutons) : ils permettent de régler plus finement la vitesse de rotation, pour éviter les bruits parasites qui peuvent survenir à certains régimes. Préférez également les rhéobus permettant de surveiller la vitesse de rotation des ventilateurs (dans le cas contraire, un ventilateur pourrait rester à l’arrêt à cause d’un réglage du variateur un peu trop bas, ce qui peut l’endommager), surtout si le variateur permet de descendre très bas en tension (la plupart des ventilateurs fonctionnent jusqu’à 5-6V, en dessous beaucoup ne démarrent pas). La surveillance des températures relève par contre vraiment du gadget : les composants qui risquent vraiment de souffrir en cas de températures trop élevées sont tous dotés de leurs propres sondes de température interne, et les sondes externes sont souvent moins précises, car difficile à positionner de façon optimale.

Comme pour les ventilateurs, le choix est large, avec des caractéristiques très variables. De préférence, pour les ventilateurs non PWM, optez pour un rhéobus proposant des variateurs analogiques (potentiomètres) plutôt que numériques (commandés par des boutons) : ils permettent de régler plus finement la vitesse de rotation, pour éviter les bruits parasites qui peuvent survenir à certains régimes. Préférez également les rhéobus permettant de surveiller la vitesse de rotation des ventilateurs (dans le cas contraire, un ventilateur pourrait rester à l’arrêt à cause d’un réglage du variateur un peu trop bas, ce qui peut l’endommager), surtout si le variateur permet de descendre très bas en tension (la plupart des ventilateurs fonctionnent jusqu’à 5-6V, en dessous beaucoup ne démarrent pas). La surveillance des températures relève par contre vraiment du gadget : les composants qui risquent vraiment de souffrir en cas de températures trop élevées sont tous dotés de leurs propres sondes de température interne, et les sondes externes sont souvent moins précises, car difficile à positionner de façon optimale.

les kits watercooling tout en un genre corsair h75 sont aussi abordables

Il ne devrait pas y avoir autre chose que le passif les autres solutions à part peut-être le watercooling sont trop aléatoires et souvent mal exploités par les constructeurs eux-mêmes.

Donc reste le passif qui est le plus cohérent car mêler la plomberie à l’exploitation de composants électroniques est juste aberrant.

Oukilédon le changement de phase actif? 😮

A part ça, la lecture fait vraiment penser à un geek revenu de ses vieux espoirs, qui a essayé le WC et a fini par revenir à de l’AC moins cher et pas beaucoup moins efficace sur une bécane pas OC comme un goret , en plus de ne pas être plus bruyant (moins d’ailleurs), mais qui garde quand même ses grigris (rhéobus…).

En y réfléchissant un peu, le WC n’a pour seul intérêt que de compenser une normalisation foireuse, un emplacement précis du socket à lui seul (Cf. BTX) suffirait à standardiser des blocs de refroidissement « parfaits » (et des boîtiers-radiateurs), avec ou sans caloduc, mais certainement pas avec une pompe et un circuit de transfert intermédiaire.

Trop « niche » ça 😀

Perdu :p

Jamais essayé le WC. Bon par contre j’ai quand même un rhéobus, oui ^^ La température de mon bureau varie grosso modo entre 15° l’hiver et 35° l’été, donc j’ai besoin de pouvoir adapter un peu la ventilation en fonction 🙂

Dans le cas du CPU seul, oui, le WC ne fait que déplacer le problème, et en contrepartie peut nécessiter un radiateur plus volumineux.

Après y a quand même le cas du circuit unique CPU + GPU. Même en standardisant au maximum, ça serait pas facile de faire un bloc de refroidissement standard unique qui marche pour les CPU et toutes les cartes graphiques.

@Matt> Apple l’a bien fait avec le Mac Pro, avec pourtant des volumes de ventes pas si énormes, c’est bien qu’une question de volonté… 😉

Après, pour les configurations plus « exotiques » (type tri/quad GPU) je dis pas, encore que des solutions existent. Une en particulier ne nécessiterait même pas de standardisation trop forte pour utiliser un unique rad « monstrueux » (équivalent à un rad WC 9×120 en terme de surface développée) pour tous les éléments sans que les composants n’aient à en supporter le poids.

Ctrl-Alt-Suppr.

@Matt> Apple l’a bien fait avec le Mac Pro, avec pourtant des volumes de ventes pas si énormes, c’est bien qu’une question de volonté… 😉

Sauf que justement, le Mac Pro c’est une machine, absolument pas faite pour être souple, avec quasiment aucun choix au niveau du matériel (3 modèles de carte graphique, dans un format propriétaire, aucun composant interne en dehors de ceux livrés de base avec la machine)…

Et malgré ça, y a déjà eu des compromis à la con, du genre les deux cartes graphiques qui sont pas identiques (la carte de gauche a pas le même design que celle de droite), qui seraient difficilement acceptable dans le monde des machines hautement configurables que sont les PC assemblés…

Faut pas oublier de dépoussiérer son PC régulièrement, sinon ça réduit l’efficacité du refroidissement et ça augmente le bruit au niveau des ventilos.

J’ai mis un Watercooling sur mon FX pour deux raisons

– Le TDP ( y’avais marqué 250watt perso mes cheveux se sont dressés sur ma tête et il m’a fallut un moment pour comprendre que AMD n’avait pas voulut se mouiller en annonçant une valeur trop faible qu’un proco débridé pourrait facilement exploser)

– La carte mère, mon dernier ventirad ( un noctua ) était un monstre qui rentrait tout juste dans le boitier et qui pesait dans les 800gr, j’ai tout simplement préféré reporter le poids sur le chassis ( parce que la boite en alu elle s’en fout) plutôt que de panique à chaque fois que je déménage. ( déménage trop souvent vas falloir penser portable).

– Et puis finalement c’était presque moins cher un WC bas/milieu de gamme tout monté qu’un bon AC alors pourquoi s’emmerder?

Finalement j’en suis comptant, j’ai surpris W8.1 overcloker mon CPU à plus de 4Ghz un flagrant déli, dommage pas eu le réflexe de faire un Prtsc

J’ai mis un WC dans un boitier Lian-Li mini-ITX, avec une Pico PSU, une GT240 et un Xeon 45W (4 coeurs + HT).

Pourquoi le WC ? Pour le plaisir de monter un truc complètement useless dans un boitier tout sauf adapter. J’en avais surtout assez de voir les températures au-dessus de 60°, pour ma CG. Depuis ma X800 GTO, ça devenait difficile de trouver bon compromis silence/température. Donc j’ai pris le contre pied : matos peu performant et WC.

@PowerBioman> cette idée se défend

Le matos est dans un mini ITX et c’est du Xeon donc…

mais le truc qui doit faire le plus de chaleur doit être la GT240 ( pour info j’ai une 570 un véritable chauffage central à elle toute seule)

Mais au final il n’y a pas de mauvaises solutions de refroidissement ou trop sur-dimensionnées.

Juste des idées qui ne conviennent pas à l’utilisateur.

Tu es conscient que de telles températures n’endommagent pas ta carte graphique… ?

Il suffit d’observer l’état d’un PCB à l’oeil nu après un an de ce régimz pour comprendre que c’est faux

Je me suis mal exprimé, d’où le mal entendu. Ce que je voulais dire, c’est que des températures au-dessus de 60°C ne devraient alerter personne… jusque dans une certaine mesure. Lorsqu’on atteint les 85, voire 90°C, là, il faut se poser des questions.

En fait, ce qui me dérange avec la formulation de PowerBioman, c’est qu’il sous-entend qu’il faille absolument avoir des températures en-dessous de 60°C. En pratique, beaucoup de GPU dépassent les 60°C en pleine charge et il fonctionnent pendant des années comme ça.

J’avais une 8800 GTS (version G80) avant, et la température en pleine charge avoisinait les 85°C. Je n’ai jamais eu aucun plantage dû à la température. Cela dit, elle faisait un boucan pas possible, ce qui m’a conduit à changer le ventirad.

Maintenant, j’ai une HD7950 et il arrive qu’elle dépasse les 60°C. Pas de beaucoup, certes, mais cela arrive — surtout en plein été.

Je ne sous-entend rien, c’est simplement ma tolérance personnelle 🙂

Franchement, tu te compliques la vie pour pas grand chose. Ne le prends pas mal, hein, je te le dis amicalement. 🙂

J’avoue que, psychologiquement, voir des températures de 60°C et plus, ça fait penser : « Ouh là, ça chauffe beaucoup ! » Mais bon, les GPU (et les chipsets de carte mère, aussi) sont prévus pour fonctionner à de telles températures. Peut-être qu’avec un offset négatif sur la sonde GPU dans ton logiciel de monitoring, ça te calmerait… ? 😉

Ca marchait bien chez Gigabyte/MSI/Abit d’ailleurs ça… 😮

Barlav > Effectivement, ce design est intéressant à plus d’un titre… un bon héritage du vieux design Zalman remis au goût du jour, mais toujours assez limité en terme de charge maxi admissible. Je suis étonné qu’ils n’aient pas voulu essayer de pousser plus loin ce concept en actif… peut-être simplement trop cher pour sortir de la niche du passif.

C’est pour ça que pour mon premier commentaire j’ai précisé que le montage était useless 😀 C’est avant tout un plaisir couplé à une pseudo excuse pour monter un WC dans un endroit absolument improbable. Au départ ma config devait être fanless et puis finalement non, en partie parce que la chauffe aurait été trop élevée à mon avis.

Après je considère qu’au-delà de 80° en usage intensif c’est nocif à moyen terme pour le matos. Il faut que ça chauffe pour que ça fonctionne bien mais je trouve que pendant un temps les CG ont suivi la même course absurde à la puissance au détriment du TDP que les CPU à l’époque des P4. La courbe s’inverse aujourd’hui et c’est une bonne chose, suffit de voir les dernières Nvidia dans le milieu de gamme par exemple.

Pourquoi spécialement dans le milieu de gamme?

Kepler a été une bonne surprise de ce côté, mais faut bien avouer qu’après Fermi c’était une nécessité… manque encore un mode « off » apparu sur GCN par contre, 10w de trop écran en veille c’est pas très trendy.

Parce que je suis surtout focaliser sur le milieu de gamme 🙂

Y a plus les moyens pour le haut de gamme 🙁

Je pense qu’il parle des cartes graphiques équipées de GPU Maxwell, c’est-à-dire les GTX 750 et GTX 750 Ti — ces dernières ayant un meilleur rapport performance/consommation que les modèles équipés de GPU Kepler.

Ca change rien au souci, c’est Kepler qui a amorcé ce virage 😮

Quand on voit le GK110, on a du mal à s’imaginer que c’est le successeur direct du GF110 (ou GF100, c’est selon). Pour aller au fond de ma pensée, si j’avais des doutes quand le GK104 a montré ses excellents résultats, du fait de la simplification architecturale qui pouvait avoir une influence notable aussi bien en conso qu’en perfs autres que ludiques, le GK110 les a fait voler en éclats.

Maxwell est une évolution qui semble bonne également, même si le gros cache peut biaiser les résultats GPGPU.

Bref… on s’est un peu écartés du sujet, quoique, le refroidissement du GPU est quelque chose d’important actuellement, surtout chez AMD qui n’a toujours pas réussi à se bouger le fion pour sortir quelque chose de correct (Cayman étant la crème de la crème de ce côté, ventilo-fraiseuse FTW).

Boh, ma 7970 siffle tellement à cause des bobines (ou transistors, ça dépend des sites qui expliquent, perso j’ai du mal à comprendre le principe qui ferait vibrer l’un ou l’autre) que je suis assez content du bruit de ventilation pour couvrir un peu le sifflement… >

Ce qui grésille c’est des inducteurs, soit « natifs » (créés pour en être), soit parasites (condos enroulés, parfois pistes).

Ca fait un bail que j’ai pas eu ce grésillement, mais les dernières fois c’était à 1000+fps, donc c’est un problème tout à fait évitable…

Il me semble que le grand coupable est la magnétostriction et électrostriction.

En fait, il existe un lien entre un champ magnétique ou électrique, et la forme d’un matériau.

C’est le principe de base des capteurs piézo (tels que des capteurs de pression) ou de certains actionneurs (comme les buses d’imprimantes).

Et comme tout phénomène physique qui se respecte, il se manifeste même (surtout?) quand on n’en veut pas 😀

(Pas de LQT cette semaine ?)

@Nico470> Ton exemple est justement bon car la 8800 qui fût en son temps un must, il y a plus de 6 ans déjà est une des dernières cartes haut de gamme à avoir été déclinée en version passive en fin de vie.

Ce qui était en général le cas des la plupart des CG.

Depuis les constructeurs n’en n’ont jamais repris le concept considérant peut-être comme acquise l’adjonction de 1 puis 2 puis 3 ventilateurs … en présentant chaque fois ces augmentations comme un progrès technique ou esthétique alors que c’est l’aveu évident d’un échec.

Car présenter un « beau » système de dispersion qui ne fait qu’augmenter la facture d’électricité est juste aberrant pour un élément sensé rester enfermé dans un boîtier clos.

L’adjonction de fenêtres latérales pour en admirer la composition étant la dernière concession à ce phénomène.

Ce type de détournement me fait penser à la métaphore des cyclistes qui descendent de vélo pour se regarder pédaler. Sont-ce réellement des cyclistes?

Faire un papier sur ce thème, certes important, est juste négliger d’autres faits comme :

– la généralisation des APU et la recherche constante des gains de perf et de passivité.

– l’apparition de Mantle qui tend à prouver qu’on aurait pu éviter cette gabegie en rationalisant le développement et l’exécution des applications.

– l’amélioration constante des perfs des SoCs ARM qui tend à prouver qu’il y a d’autres voies à explorer en la matière.

Car si il y a un énorme écart entre un écran 5″ et un 22″, l’énergie dépensée pour animer leur 1920×1080 points communs devrait tendre à être identique (ce que fait très bien le RbPi)

La moquette, c’est mal…

Le G80 (« vraies » GF8800) n’a JAMAIS été décliné en fanless, peut-être le G92, et encore, j’en ai pas souvenir.

Les cartes graphiques ne sont plus fanless depuis les premières GeForce et Radeon, même un petit pwal avant ça (le Rage128 avait déjà un ventilo, le TNT2 Ultra aussi, flemme de chercher les autres), pourtant la conso était très loin des cartes actuelles…

Le « vrai » fanless dépasse péniblement les 25w, à 75w on continue à trouver des cartes sans ventilo d’origine qui ne ressemblent pas à des barbecues, mais au-delà ça devient très problématique et ça impose dans tous les cas une ventilation extérieure.

Pour le reste : on est dans une société capitaliste, l’innovation ou l’amélioration ne peuvent y être qu’un moyen et en aucun cas un objectif. On y peut rien (enfin, si… mais personne n’a encore trouvé comment), toutes les politiques nationales/fédérales ou presque ont oublié ce qu’est la valeur ajoutée en chemin, ce qui ne les empêche pas d’avoir recours massivement à la TVA et de mesurer l’activité d’un état à de simples mouvements financiers sans se préoccuper de leur utilité.

@[Ctrl][Alt][Suppr.]>http://www.adnpc.net/[…]800-gt-passives.html

« La moquette, c’est mal… »

Bah, pourquoi pas si tu te sers de ta CG comme allume-cigare.

@loulnux> Effectivement, il a réellement existé au moins une 8800GT à base de G92, un shrink allégé du G80 (90 -> 65nm, voire 55nm vu le retard qui avait été accumulé, 384 -> 256bits), qui plus est castré (1 bloc désactivé sur 8 ), et surtout qui surchauffait en conditions réelles si on ne lui soufflait pas dessus…

@[Ctrl][Alt][Suppr.]> Abjection votre horreur j’en connais une qui tourne H/24 depuis 6 ans sans aucun artifice et dédiée au montage video + CUDA

Montage vidéo accéléré CUDA tu veux dire? Pas la peine d’en dire plus…

+1.

Mon ancienne carte graphique était même à plus de 60° au repos ^^

J’avais utilisé MSI Afterburner pour modifier la courbe de réponse du ventilateur, en conf standard il était à 40% jusqu’à 50° puis montait progressivement pour atteindre 100% aux alentours de 75-80°, j’ai remplacé ça par un 20% jusqu’à 70° puis une montée jusqu’à 100% à 90°.

Ça ne m’a jamais posé le moindre problème de fonctionnement, et du coup ça me permettait d’avoir une machine beaucoup plus silencieuse au repos.

DmC Devil May Cry :

– GeForce GTX 590 (Gigabyte) : 90°C, 3 ventilateurs à 100%

Arrêt brutal du PC au bout de 30min de jeu.

Impossibilité de jouer en été avec 30°C à l’ombre, arrêt brutal au bout de 5min de jeu. L’appartement gagnait 3°C grâce à cette carte graphique, c’était très pratique en hiver.

– GeForce GTX 670 (Asus) : 60 °C, 2 ventilateurs à 30%

Une température excessive a quand même des conséquences sur le fonctionnement du PC.

C’est important de bien choisir sa carte graphique.

Je m’étais mal exprimé. J’ai expliqué ce que je voulais dire dans ma réponse à Loulnux.

Par contre, je trouve que la GTX 590 n’est pas vraiment un bon exemple. C’était pas ces cartes graphiques qui « fondaient » sur place lors de scénarios totalement anodins (genre, on lance un jeu qui ne sollicite pas le GPU plus que la moyenne) ?

J’ai monté un WC CPU/GPU lors de ma période geek … une fois mais pas 2.

Cher pour avoir du matos correct (surtout le WB GPU), imposant (rad 360, …) et franchement « tue geekerie ». Une fois monté, la moindre bidouille prend un temps infini et peut être périlleux si on multiplie les éléments refroidis (purge du système, tous les éléments reliés par des tuyaux, …).

WC un CPU seul ne sert (quasi) à rien. C’est pas plus silencieux et ca refroidit pas mieux sauf gros gros OC.

Y rajouter le GPU peut avoir un intérêt car ça chauffe plus et les solutions en aircooling sont moins nombreuses mais c’est cher payé pour le gain espéré.

Au final, le WC est à réserver aux bidouilleurs qui souhaitent gâcher du temps et de l’argent pour cette passion.

@-Oo-> Tout à fait d’accord, en plus c’est vraiment chiant de défaire le système de refroidissement d’une carte graphique pour mettre quelque chose de mieux, et puis ça fait sauter la garantie du constructeur.

Finalement je me suis contenté d’une graisse thermique Arctic Silver et d’un ventirad Cool Master sur le CPU, la température max est 50° C et puis c’est très silencieux avec une alimentation Seasonic.

Il suffit juste d’avoir les bons éléments au départ.

Pour la convection naturelle, je viens de tester un nofan (le petit de 300gr dissipant 80W), j’en suis ravi; bien meilleur que tous les designs tours de 1kg, leger et pas plus volumineux.

C’est des micro-caluducs et l’air circule bien autour:

http://www.quietpc.com/nof-icepipe